eISSN: 2093-8462 http://jesk.or.kr

Open Access, Peer-reviewed

eISSN: 2093-8462 http://jesk.or.kr

Open Access, Peer-reviewed

Wonsup Lee

, Hayoung Jung

, Heecheon You

10.5143/JESK.2020.39.5.437 Epub 2020 November 03

Abstract

Objective: A database of Korean 3D heads was developed using a template model registration method to increase its applicability for ergonomic product design.

Background: A 3D scanned head database of more than 8,500 Koreans was established through the Size Korea project since 2004. While the anthropometric information of Size Korea has been used in the design of various products, 3D scan images have been rarely used because post-processing and landmarking are needed.

Method: This study proposed a hybrid template model registration method consisting of steps of (1) global registration using the bounded biharmonic weight (BBW) algorithm based on 11 manually defined landmarks and (2) local optimization using the iterative closest point (ICP) algorithm. A head template containing the locations of 43 head and facial landmarks was used to create a template-registered head image database of 8,536 males and females (age: 7 to 77) of Korean civilians.

Results: The template-registered images of Korean heads including the 43 anthropometric landmarks for anthropometric measurement of head dimensions were generated. The template-registered heads satisfy high correspondence in terms of the mesh structure.

Conclusion: This study proposed a method of template model registration for the head and a database containing 8,536 template-registered heads was established by applying the proposed method.

Application: The head database would be applied for anthropometric measurement of the head, analysis of a head sizing system, development of representative head models, analysis of shape variation, virtual evaluation of head wearable products, and design of ergonomic products such as medical masks, goggles, prosthetics, personal protective equipment, and sportswear, which require good fit and comfort.

Keywords

Head and face 3D head scan database Digital head model Template model registration 3D anthropometry Ergonomic product design

인체에 착용되거나 밀착되는 제품의 설계는 해당 사용자 집단의 인체 치수 및 형상 특성을 고려하여 개발될 필요가 있어 이를 위해 3차원 인체 스캔 데이터가 활용되고 있으나, 3차원 스캔 데이터의 가공 및 활용의 효율성 측면에서 한계가 있다. 3차원 인체 스캔 데이터는 인체 밀착성과 착용성이 좋은 제품의 설계에 활용되지만, 데이터를 효과적으로 활용하기 위해서는 데이터의 후처리(post-processing) 과정이 필수적이다. 3차원 인체 스캔 데이터의 예로는 사이즈 코리아(Size Korea) 약 10,000명(KATS, 2004; KATS, 2010), Civilian American and European surface anthropometry resource (CAESAR) 약 4,500명(Robinette et al., 2002), 그리고 US Army 2013 Anthropometric Survey (ANSUR II) 약 6,000명(Gordon et al., 2014) 등이 있다. 이들 3차원 인체 스캔 데이터는 그 양이 방대하기 때문에 이들 데이터를 수작업으로 가공 및 분석하기에는 많은 노력이 요구된다(Lee et al., 2016; Lee et al., 2018b). 일반적으로, 3차원 스캔된 인체 이미지로부터 치수 또는 형상을 분석하기 위해서는 원본 3차원 스캔 이미지에 미측정된 구멍 부위를 메우거나(hole-filling), 거친 표면을 매끄럽게 하거나(surface smoothing), 인체 참조점(landmark)을 표시하는 등의 후처리 작업이 필요하다(Lee et al., 2016). Lee et al. (2018b)은 2,300명의 CAESAR 데이터의 3차원 머리 형상을 수작업으로 정교하게 후처리(예: 헤어스타일 제거)하였는데, 2,300명의 후처리에 총 260시간 정도가 소요되었다.

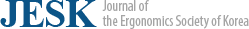

3차원 인체 스캔 데이터의 후처리에 소요되는 시간과 노력을 최소화하기 위해 템플릿 모델 정합(template model registration)이라는 컴퓨팅 기술이 사용되고 있다. 템플릿 모델 정합(Figure 1)은 템플릿 이미지를 그 대상인 3차원 인체 스캔 이미지에 정합시켜, 템플릿 이미지가 가진 mesh의 구조를 유지하면서 그 형상은 대상 이미지에 일치되도록 하는 기술이다(Allen et al., 2003; Anguelov et al., 2005; Lee et al., 2017a; Lee et al., 2020a). 원본 3차원 인체 스캔 이미지들은 점군(point-cloud)의 개수와 mesh의 구성이 서로 상이하지만, 템플릿 이미지를 이들 정합 대상 이미지들에 정합하게 되면, 대상 이미지들의 데이터의 점군 및 mesh의 구성이 동일하게 가공되기 때문에 데이터의 양이 방대하더라도 통계적 처리나 복잡한 컴퓨팅 기술(예: 기계학습)을 통한 기술적인 분석이 가능해진다(Ball et al., 2010; Baek and Lee, 2012; Luximon et al., 2012; Zhuang et al., 2013; Lee et al., 2017a; Li et al., 2017; Lee et al., 2020a). 또한, 템플릿 모델 정합의 과정에서 원본 3차원 스캔 이미지에 미측정된 구멍을 메우거나, 거친 표면을 정리하는 등의 후처리 작업이 자동으로 처리될 수 있다(Allen et al., 2003; Hirshberg et al., 2012; Ballester et al., 2014; Yang et al., 2014). 그리고 템플릿 모델 정합을 통해 템플릿 상의 인체 측정 참조점(landmarks)들이 대상 이미지의 상에 복제되어 인체 부위들이 자동 측정될 수도 있다(Tsoli et al., 2014; Ballester et al., 2016). 이러한 장점으로 인해 템플릿 모델 정합 기술은 인간공학적 제품 설계 및 평가 연구에 적용되고 있다(Baek and Lee, 2012; Luximon et al., 2016; Lee et al., 2017a; Lee et al., 2017b).

국가기술표준원은 한국인 인체치수조사보급 사업인 사이즈 코리아 사업을 통해 10여년에 걸쳐 한국인 3차원 인체 스캔 데이터를 수집하였으나 활용도 측면에서 한계가 있다. 국가기술표준원은 1979년에 제1차 한국인 인체치수조사 사업을 수행한 이후, 2003년~2004년에 걸쳐 진행된 제5차 사업에서 8~75세 한국인 남녀 5,000여 명의 3차원 인체 측정 데이터를 수집하였다(KATS, 2004). 이후, 2010년~2013년에 추진된 제6차 사업에서 7~69세 한국인 남녀 약 5,000여 명의 3차원 인체 스캔 이미지를 추가로 수집하였다(KATS, 2010). 사이즈 코리아 3차원 인체 스캔 데이터는 3차원 치수 측정과 3차원 대표 형상 분석 등에 다양하게 활용되었으며, 3차원 대표 형상 자료 및 관련 보고 자료들은 사이즈 코리아 홈페이지(https://sizekorea.kr)를 통해 배포되고 있다. 하지만, 10,000여 명의 사이즈 코리아 3차원 인체 스캔 원본 데이터는 전술한 바와 같이 데이터의 후처리 및 가공에 시간과 비용이 드는 이유로 산업 및 연구에 직접적으로 활용되기 어려운 것으로 사료된다(Lee et al., 2018b; Lee et al., 2019). 따라서 템플릿 모델 정합과 같은 컴퓨터 기술을 이용한 데이터의 효과적인 가공을 통해 활용도가 제고될 필요가 있다.

본 연구는 사이즈 코리아 3차원 인체 스캔 데이터 중 8,500여 명의 머리 이미지에 템플릿 모델을 정합하여 얻은 템플릿 정합된 머리(template-registered heads) 데이터베이스를 개발하였다. 템플릿 정합 기술은 매우 다양한데, 본 연구에서는 Besl and McKay (1992)이 처음 제안하고 이후 많은 연구에서 활용된 iterative closest point (ICP) 방법과 3차원 mesh 데이터의 변형(deformation) 기술 중 하나인 bounded biharmonic weight (BBW) (Jacobson et al., 2014)를 함께 사용하여 템플릿 정합된 모델들 간의 mesh 구조의 유사도를 제고하였다. 템플릿 모델의 정합을 위해 필요한 것으로 파악된 11개의 인체 측정 참조점을 정합 대상인 원본 머리 스캔 이미지에 표기하면, 이들 참조점의 정보를 이용하여 템플릿 모델이 원본 머리 스캔 이미지에 자동으로 정합된다. 이 기술을 이용하여 본 연구는 사이즈 코리아 3차원 머리의 템플릿 정합된 이미지 데이터베이스를 구축하였다.

2.1 Hybrid template model registration

인간공학 연구에 템플릿 모델 정합 기술을 적용함에 있어 중요한 점 중 하나는 템플릿 모델 정합된 이미지들 간의 mesh 구조가 일관적이어야 한다는 것이다. 템플릿 이미지와 대상 이미지는 크기와 형상이 서로 다른데, 두 이미지에서 서로 정합될 부위들(예: 코뿌리, sellion; 코끝, pronasale; 턱끝, promentale; 입술가장자리, cheilion; 눈구석, ectocanthion; 귀구슬, tragion 등) 간에 연결을 해두어야 여러 템플릿 정합된 이미지들의 mesh 구조가 서로 일관적이게 된다(Lee et al., 2016; Lee et al., 2017a; Lee et al., 2017b). 서로 정합될 부위들이 미리 정의되어 있지 않으면 템플릿 이미지가 대상 이미지에 임의적으로 정합되는데, 예를 들어, 코끝 부위가 콧대 위에 정합되거나, 눈구석 부위가 뺨 부위에 정합되는 경우가 발생한다. 템플릿 모델 정합을 통해 템플릿 모델에 정의되어 있는 인체 측정 참조점들이 대상 이미지의 해당 참조점 위치에 표기되기 때문에, 템플릿 정합된 이미지들을 인체측정학적 연구 및 인간공학적 제품 설계 등에 활용하기 위해서는 템플릿 이미지의 인체 부위들이 대상 이미지의 해당 인체 부위에 정확하게 정합되는 것이 필요하다.

본 연구의 선행 연구는 얼굴의 특정 참조점들을 기반으로 템플릿 이미지의 전반적 크기와 특정 부위의 위치를 대상 이미지에 맞게 대략적으로 조절(global registration)한 후, 세부적인 형상을 정합(local optimization)하는 하이브리드 템플릿 모델 정합 방법(hybrid template model registration)을 제안하였다(Lee et al., 2017a; Lee et al., 2019; Lee et al., 2020a). 먼저, global registration에는 체표변형 방법이 적용되었다. 체표변형은 3차원 이미지를 구성하는 각 점(vertex)들과 참조점들 간의 관계인 변형 계수(weight)를 기반으로 수행되는데, 예를 들어, 템플릿 정합 과정에서 참조점 중 하나인 코끝점의 조절되면, 코끝점 주변의 점들은 코끝점과의 변형 계수를 바탕으로 그 위치들이 함께 조절된다. 특정 측정 참조점들을 기반으로 템플릿 이미지의 크기와 형상을 대략적으로 조절하는 global registration에는 Jacobson et al. (2014)이 개발한 체표변형(skin deformation) 방법인 bounded biharmonic weight (BBW) 기법이 적용되었다. 그 다음 단계인 local optimization에는 iterative closest point (ICP) 기법이 적용되었는데, ICP 기법은 템플릿 이미지를 구성하는 각 점과, 해당 점들과 matching이 되는 대상 이미지의 점들 간의 Euclidean 거리를 최소화하는 아핀 변환(affine transformation)을 반복적으로 계산함으로써 수행된다. 본 연구는 체표변형을 통해 템플릿 이미지와 대상 이미지를 대략적으로 정렬(align)한 상태에서 무강직성(non-rigid) ICP 방법을 적용하여 템플릿 이미지의 형태를 대상 이미지에 맞게 변형(deform)시키면서 정합하였다. 본 선행 연구에서는 하이브리드 템플릿 이미지 정합 기술을 통해 Figure 2와 같이 템플릿 정합된 이미지 간의 mesh 구조가 일정하게 되도록 하였다(Lee et al., 2017a; Lee et al., 2017b). 예들 들어, 모든 템플릿 정합 이미지에서 코 끝을 구성하는mesh들은 동일하게 코 끝에 위치하며 그 주변의 mesh 형태의 유사성이 높다.

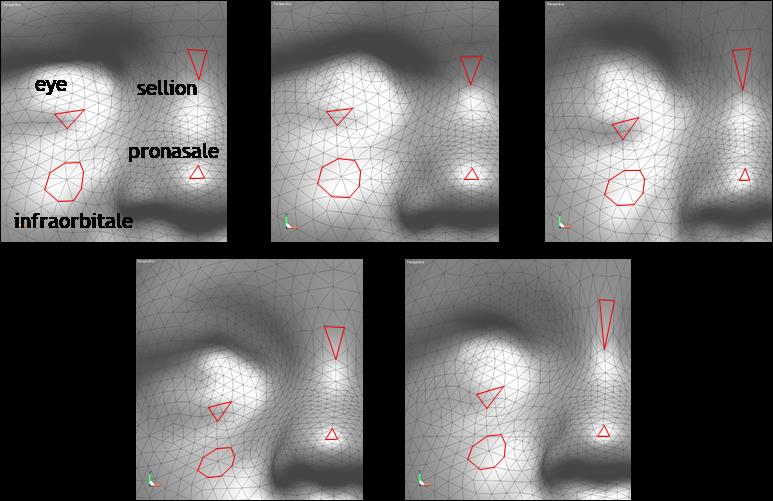

2.2 Applications of template-registered head images

템플릿 정합된 이미지는 인체 측정, 형상 분석, 제품 설계 등에 유용하게 활용될 수 있다. 먼저, 템플릿 모델 정합 과정에서 템플릿 이미지로부터 대상 이미지에 참조점들이 복제되며, 이를 기반으로 인체 크기들이 자동으로 계측될 수 있다. 예를 들어, 본 선행 연구(Lee et al., 2019)는 하이브리드 템플릿 모델 정합 방법을 이용하여 Lee et al. (2018b)이 구축한 24개의 참조점들이 표기되어 있는 2,300명의 머리 스캔 데이터에 템플릿 이미지를 정합하면서 템플릿 이미지에 정의되어 있는 추가적인 19개의 참조점을 자동으로 표기하였다(Figure 3). 참조점은 템플릿 모델의 특정 점군의 번호로서 정의되는데, 가령, 1,000개의 점군으로 구성된 템플릿 모델에서 123번째 점이 코끝점으로 정의되어 있다고 할 때, 코끝점을 제외한 다른 점들을 이용하여 템플릿 모델 정합 후 코끝점의 위치는 템플릿 정합된 모델의 123번째 점의 위치가 된다. 기존 연구는 이와 같은 방법을 이용하여 24개의 참조점을 이용하여 템플릿 모델을 정합한 후, 템플릿 모델에 사용되지 않은 19개의 참조점의 위치를 파악하였다. 이 때 하이브리드 템플릿 모델 정합 방법이 서로 다른 사람에게 mesh 구조를 유사하게 정합하는 특성으로 인해 머리의 형태적 특징 상의 해당 참조점이 표기되어야 할 위치에 19개의 참조점들이 표기될 수 있었다. 43개의 머리 관련 참조점들은 기존 연구들(Hughes and Lomaev, 1972; Hack and McConville, 1978; Alexander et al., 1979; Clauser et al., 1988; Oestenstad et al., 1990; Young, 1993; Han and Choi, 2003; Ahn and Suh, 2004; Kim, 2004; Kim et al., 2004; KATS, 2004; Yokota, 2005; Zhuang and Bradtmiller, 2005; Oh and Park, 2010; Lee et al., 2013)에서 제시한 122개 측정항목 및 해당 참조점들을 이용하여 측정할 수 있는 세부 치수들을 측정하는 데 사용될 수 있다. 템플릿 모델 정합 방법을 이용한 인체 치수 측정은 측정 시간을 크게 절약한다(Liang et al., 2013; Tsoli et al., 2014; Lee et al., 2019).

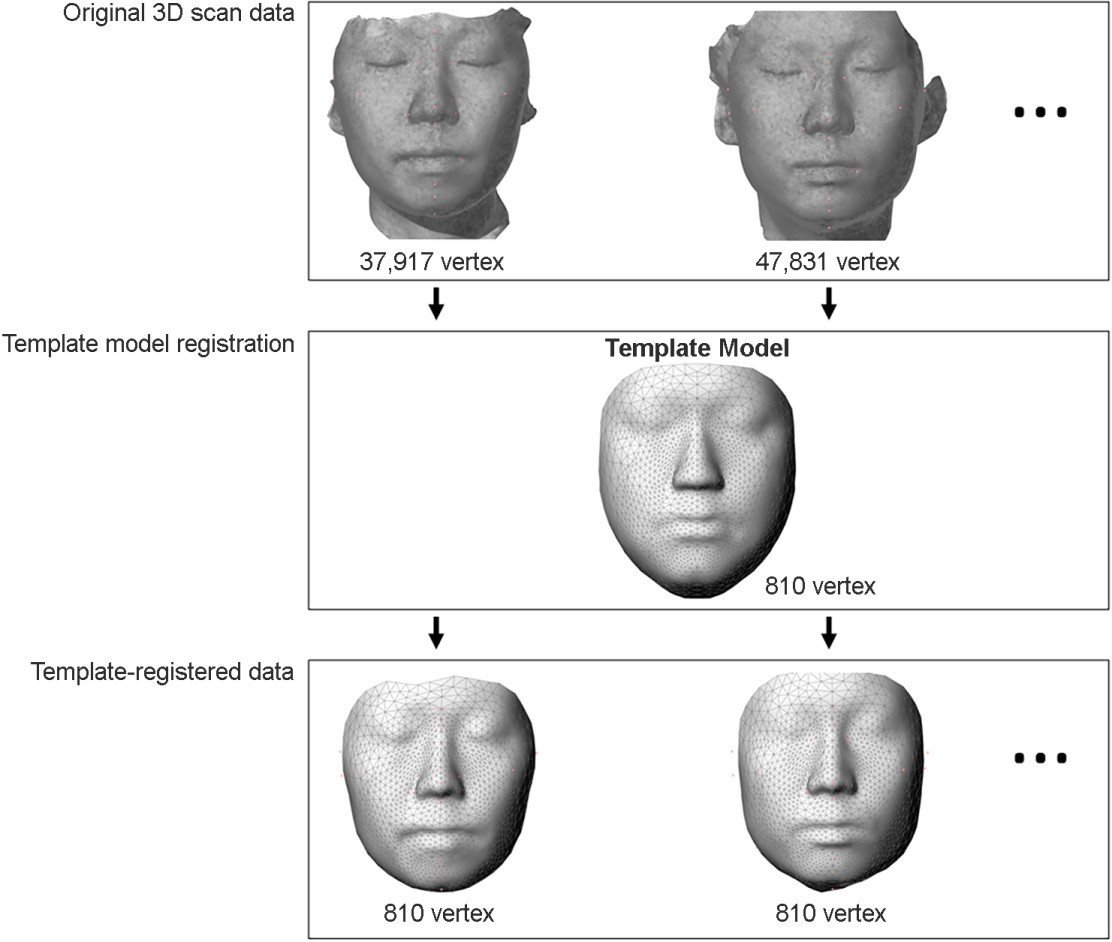

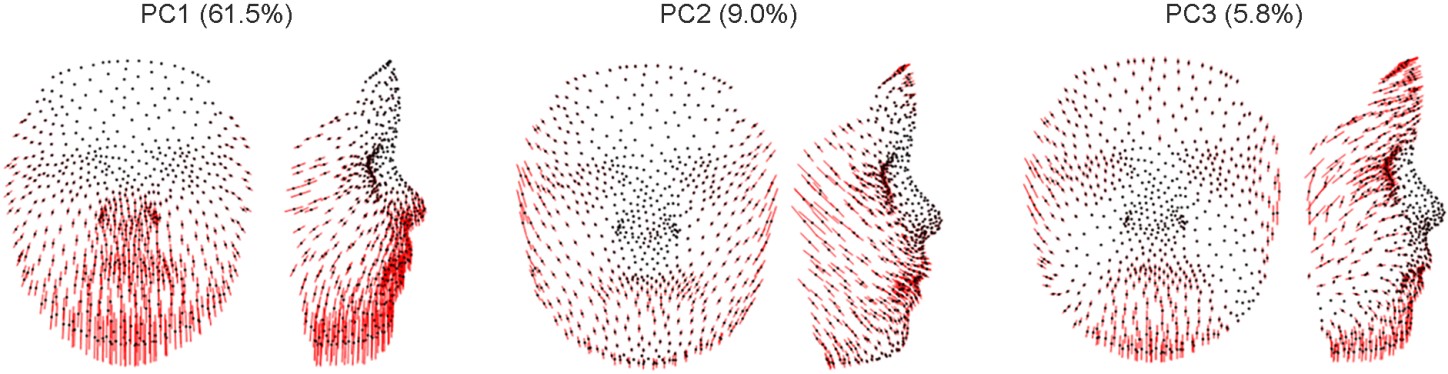

둘째, 템플릿 정합된 이미지들은 동일한 mesh 구조를 가지므로 같은 mesh에 대한 서로 다른 인체 이미지들 간의 상관관계 및 측정치의 변동성(variation)이 주성분 분석(principal component analysis; PCA)으로 분석될 수 있다. Mesh를 구성하고 있는 점군의 좌표, 점군의 normal vector, 삼각 mesh의 normal vector, 그리고 삼각 mesh를 구성하는 edge vector 등의 3차원 좌표(x, y, z) 값들을 주성분 분석의 입력값으로 하여 분석하면 여러 인체 형상들 간의 변동성이 Eigen vector로서 분석될 수 있다(Allen et al., 2003; Xi and Shu, 2009; Ball et al., 2010; Chu et al., 2010; Baek and Lee, 2012; Zhuang et al., 2013; Lee et al., 2017a; Li et al., 2017). 예를 들어, 코를 구성하는 삼각 mesh들의 좌표 정보들을 활용하면 사람들 간에 코의 크기와 형상의 변동성(variation)를 알 수 있다. 본 연구의 선행 연구(Lee et al., 2017a; Lee et al., 2017b)는 어린이용 의료 마스크 설계를 목적으로 템플릿 정합된 0~7세 어린이 얼굴 스캔 이미지들을 구성하는 모든 점들의 3차원 좌표를 입력값으로 하는 주성 분석을 통해 얼굴 형상의 변동성을 분석하였다(Figure 4). Figure 4의 빨간색 선은 각 점의 Eigen vector 방향으로의 standard deviation × ±3 방향만큼의 변동성을 시각화한 것으로, 이는 기존 연구들(Luximon et al., 2010; Luximon et al., 2012; Zhuang et al., 2013)이 3차원 형상의 변동성 분석 시 제시한 방법이다. Figure 4의 예시에서 해석될 수 있는 바에 따르면, 세 가지 주성분(principal component, PC)은 76.3%의 설명력을 가지며, 첫 번째 주성분을 예로 들면 61.5%의 설명력을 가지고 얼굴의 길이 방향(코뿌리점을 원점으로 함)으로의 변동성을 주로 설명한다. 이는 어린아이의 성장과 연관하여 설명될 수 있다.

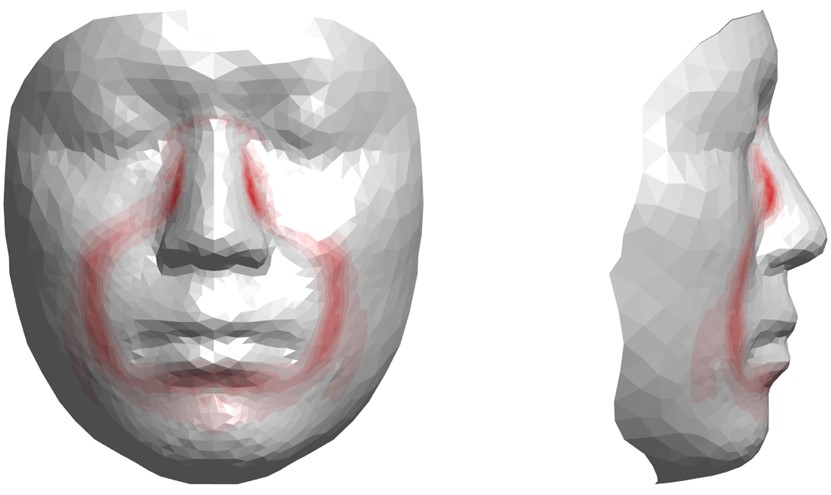

마지막으로, 템플릿 정합된 이미지들은 유한요소(finite element; FE) 분석을 통해 제품 착용 또는 사용 시의 인체에 가해지는 접촉 압력(contact pressure)를 분석하는 데에 활용되었다. Lee et al. (2018a)는 유한요소 분석 방법을 활용하여 템플릿 정합된 이미지들의 접촉 압력을 분석하는 방법을 제안하였다. 유한요소 분석 방법은 mesh 구조로 된 인체 또는 사물 데이터에 외력을 가하였을 때 mesh들이 어떻게 힘을 받거나 변형되는지를 계산할 수 있다. 이 때 템플릿 정합 방법을 통해 머리 데이터들의 mesh 구조를 일관적으로 만든 후 유한요소 분석을 적용하면, 제품(예: 산소 마스크) 가상 착용 상황에서 특정 인체 부위(예: 콧대)를 구성하는 특정 mesh들(예: 콧대를 구성하는 mesh들)에 가해지는 접촉 압력을 분석할 수 있다(Figure 5). Lee et al. (2020b)는 Lee et al. (2013)이 수집한 336명의 한국 공군조종사 얼굴과 Lee et al. (2018b)이 구축한 2,299명의 미국인 머리의 템플릿 정합된 이미지들을 사용하여 각각 공군조종사 산소 마스크와 virtual reality (VR) 헤드셋의 접촉 압력을 분석하였다. 여러 사람의 템플릿 정합된 이미지들에 특정 제품을 가상 착의함으로써 사람마다 다르게 분석된 접촉 압력 데이터들을 활용하면, 접촉 압력의 최대치, 평균치, 그리고 분산 측면에서 해당 제품의 형상이 여러 사람에게 적합한 정도를 분석할 수 있다. 인체에 보다 적합한 형상은 접촉 압력의 최대치가 낮고, 평균치가 적절하며, 분산(예: 표준편차)은 작아 적절한 압력이 얼굴에 고르게 분산되는 형태적 특징을 가진다. 해당 제품의 형상을 변형해가면서 유한요소 분석을 통한 접촉 압력 분석을 반복적으로 시행하면, 여러 사람에게 적합한 최적의 제품 형상을 탐색할 수 있다.

본 연구는 선행 연구에서 제안한 하이브리드 템플릿 정합 방법을 적용하여 사이즈 코리아 사업을 통해 수집된 8,536명의 3차원 머리 스캔 이미지에 대한 템플릿 정합 이미지 데이터베이스를 구축하였다. 사이즈 코리아의 3차원 머리 스캔 원 데이터(raw data)는 구멍메우기 및 인체 측정 참조점 표기와 같은 후처리 작업이 되어 있지 않기 때문에 해당 데이터들을 제품의 설계에 요긴하게 활용하기 위해서는 데이터의 가공이 선행되어야 한다. 본 연구는 11개의 참조점만 표기하면 템플릿 이미지를 정합하는 반자동(semi-automatic) 템플릿 정합 방법을 적용하여 8,536명의 머리에 대한 템플릿 정합된 3차원 이미지를 데이터베이스화하였다.

3.1 Head scan data

본 연구에 활용된 데이터는 사이즈 코리아 사업에서 2004년, 2010년, 2012년, 2013년에 측정된 7~77세의 한국인 남녀에 대한 3차원 머리 스캔 데이터이다. 연도별 측정 수는 2004년 5,168명(연령대: 7~77세), 2010년 848명(연령대: 20대, 30대), 2012년 1,228명(연령대: 40대, 50대, 60대), 그리고 2013년 1,292명(연령대: 10대)이며, 남성은 4,302명이고 여성은 4,234명이다. 연령대별 및 성별 측정 수는 Table 1과 같다.

|

Gender |

Age group |

Total |

||||||

|

7~9 |

10s |

20s |

30s |

40s |

50s |

≥60s |

||

|

Male |

105 |

1,335 |

754 |

715 |

462 |

465 |

466 |

4,302 |

|

Female |

105 |

1,280 |

728 |

721 |

476 |

451 |

473 |

4,234 |

|

Total |

210 |

2,615 |

1,482 |

1,436 |

938 |

916 |

939 |

8,536 |

3.2 Marking of facial landmarks

3.2.1 The least number of facial landmarks

머리의 템플릿 정합 과정에서 참조할 필요가 있는 최소 개수의 대표 인체 측정 참조점들이 실험적인 방법으로 파악되었다. 대표 인체 측정 참조점은 템플릿 이미지가 대상 이미지에 정합될 때 대상 이미지들이 동일한 mesh 구조를 가지게 하며, 대표가 아닌 나머지 참조점들(비대표 참조점)이 대상 이미지 상의 해당 참조점이 표기되어야 할 곳에 정확하게 위치될 수 있도록 하기 위해 필요하다. 본 연구는 인체 측정 참조점들을 추가하거나 제외해가면서 템플릿 정합된 이미지 상에 비대표 참조점들이 정확하게 위치하였는가를 확인하는 방법으로 대표 인체 측정 참조점들을 선정하였다. 대표 인체 측정 참조점은 눈살점(glabella), 코뿌리점(sellion), 코끝점(pronasale), 코밑점(subnasale), 양쪽 입술가장자리점(cheilion), 앞턱끝점(pronasale), 양쪽 눈초리점(ectocanthion), 양쪽 귀구슬점(tragion), 머리마루점(vertex), 뒤통수점(occiput)의 13개 점으로 파악되었다. 이 중에서 머리마루점과 뒤통수점의 위치는 대상 이미지의 헤어스타일로 인해 대상 이미지 상에 직접 표기하기 불가능하기 때문에, 해당 사람의 머리 크기에 대한 직접측정치를 이용하여 그 위치를 추정하였다. 머리마루점의 수직 방향(Y축 방향) 위치는 머리수직길이(head height)의 직접측정치를 이용하여 결정되었으며, 뒤통수점의 깊이 방향(Z축 방향) 위치는 머리길이(head length)의 직접측정치를 바탕으로 정해졌다. 나머지 11개의 대표 인체 측정 참조점은 템플릿 정합 과정에서 수작업으로 표기되었다.

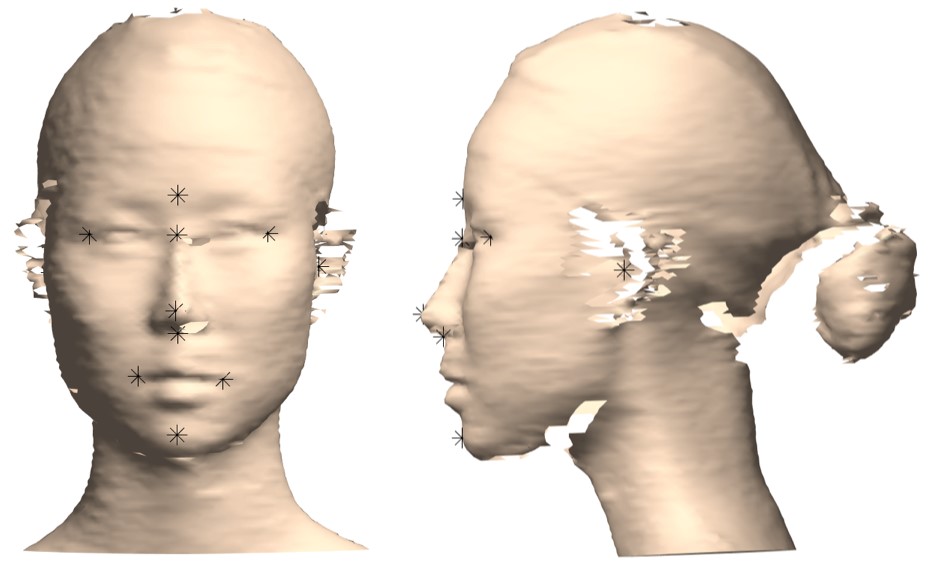

3.2.2 Method of landmark marking

본 연구는 11개의 대표 인체 측정 참조점을 간단하게 표기할 수 있는 프로그램을 개발하여 활용하였다. 대표 인체 측정 참조점 표기 프로그램은 Matlab 2020a (The MathWork Inc., MA, USA)를 이용하여 개발되었다. 본 개발된 프로그램을 이용하면 사이즈 코리아 3차원 머리 스캔 데이터를 하나씩 불러와 정면(front view)에서 귀구슬점을 제외한 9개 대표 인체 측정 참조점을 표기하고, 좌우 측면(side view)에서 왼쪽과 오른쪽 귀구슬점을 각각 표기할 수 있다(Figure 6). 먼저 코뿌리점을 표기하여 이를 원점(0, 0, 0)으로 삼는다. 그리고 앞턱끝점을 표기하여 머리의 상하 방향 각도를 조절한다. 머리를 밑으로 숙이고 있는 경우 머리를 드는 방향으로 대상 이미지의 각도가 조절된다. 그리고 나서 양쪽 눈초리점을 표기하여 머리의 좌우 방향 각도를 조절하였다. 이와 같이 우선적으로 4개의 참조점(코뿌리점, 앞턱끝점, 양쪽 눈초리점)을 표기하여, 머리가 정면을 바라보며 코뿌리점이 원점이 되도록 모든 데이터를 정렬(alignment)하였다. 그리고 나서 나머지 7개 참조점을 순서(눈살점, 코끝점, 코밑점, 오른쪽 및 왼쪽 귀구슬점, 오른쪽 및 왼쪽 입술가장자리점)에 따라 표기하였다. 참조점의 표기는 Cintiq DTK-2260 (Wacom Co. Ltd., Japan) 디스플레이형 타블렛을 이용하여 해당 참조점 위치를 터치펜으로 표기하는 직관적인 방법으로 수행되었다. 참조점 표기는 인체 측정 전문가 한 사람에 의해 수행되었으며, 8,536명의 참조점 표기에 약 24시간 정도 소요되었다(10초/머리).

3.3 Hybrid template model registration approach

하이브리드 템플릿 모델 정합은 Matlab 2020a를 이용하여 개발된 템플릿 모델 자동 정합 프로그램을 이용하여 Figure 7.a와 같은 여섯 단계의 절차로 진행되었다. 먼저, 3,508개의 점군과 6,974개의 삼각 mesh로 구성된 머리의 템플릿 이미지(Figure 7.b)가 로딩된다(S1). 그리고 템플릿 이미지를 정합할 대상 이미지 및 해당 이미지에 사전 표기해 둔 13개의 참조점 정보가 한 사람씩 로딩된다(S2). 해당 사람의 원본 머리 이미지에 템플릿 이미지가 본 연구에서 제안한 하이브리드 템플릿 이미지 정합 방법에 따라 global registration (S3) 및 local optimization (S4)의 단계를 통해 정합된다. 템플릿 이미지가 정합되는 과정에서 사이즈 코리아에서 직접 측정한 항목(예: 머리길이, 머리높이, 머리너비, 머리둘레, 얼굴길이, 눈동자사이너비, 입너비 등)의 측정치들을 참고로 하여 템플릿 정합된 이미지의 정합 정확도가 제고되었다. 그리고 나서 정합된 템플릿 이미지 상에서 사전 정의되지 않은 30개의 추가적인 참조점들이 자동으로 파악된다. 마지막으로, 템플릿 정합된 이미지와 총 43개의 머리 관련 참조점들이 파일로 저장된다. 한 사람에 대한 템플릿 모델 정합이 완료되면 다른 사람의 머리에 템플릿 모델 정합이 진행되며, 모든 8,536명에 대한 템플릿 모델 정합이 본 연구에 의해 개발된 프로그램에 의해 자동으로 진행되었고 총 7시간 정도 소요되었다(3초/머리).

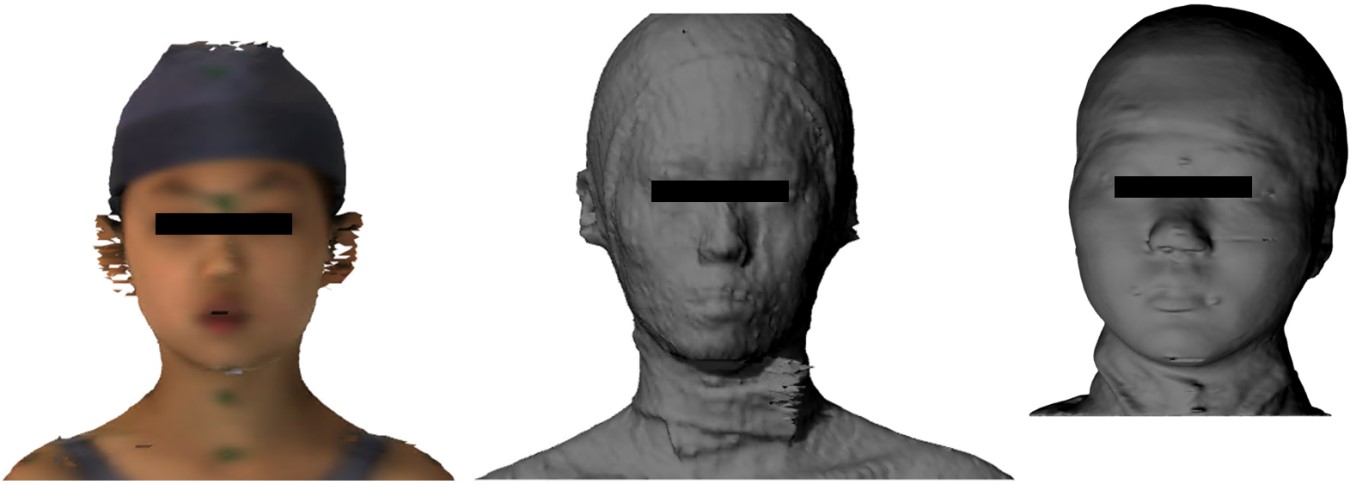

본 연구에서 제안된 하이브리드 템플릿 모델 정합 기술은 데이터 품질의 향상, 데이터 형식의 일원화, 데이터의 용량 감소 및 데이터의 활용도 제고 측면에서 유용하다. 먼저, 데이터의 품질 측면에서 기존의 사이즈 코리아의 3차원 머리 스캔 데이터는 Figure 6과 Figure 8에 예시된 것과 같이 스캔되지 않은 부분이 있거나, mesh의 표면이 거칠거나, 헤어스타일로 인해 머리 모양이 부자연스러운 문제가 있어 수정이 필요하였다. 방대한 양(예: 사이즈 코리아의 3차원 머리 이미지 8,536개)의 원본 3차원 스캔 데이터의 수정은 시간과 노력 측면에서 많은 비용이 소요된다(Lee et al., 2018b). 템플릿 모델 정합 기술은 스캔되지 않은 부위를 보간하고 mesh의 표면을 정돈하고 머리 모양을 보정함으로써 데이터의 품질이 향상되었다. 수작업에 소요된 시간에 있어 본 연구는 11개의 참조점을 표기하는데 1명에 10초의 시간이 소요되었는데, 이는 CAESAR 데이터의 머리를 수작업으로 보정(6.8분/1명)한 Lee et al. (2018b)의 방법에 비해 1/40 수준으로 수작업 소요 시간이 단축된 것이다. 데이터 형식의 일원화 측면에서 기존 3차원 스캔 데이터는 머리의 크기에 따라 머리를 구성하고 있는 점군 및 삼각 mesh의 수가 상이하고, 사람들 간 mesh 구조에 일관성이 결여되었다. 반면, 템플릿 모델 정합 기술을 이용하면 템플릿을 형성하고 있는 mesh의 구조가 원본 머리 이미지들에 유사하게 정합되기 때문에, 서로 다른 사람들 간에도 mesh 구조는 일관적이고 mesh의 개수가 같다. 사람들 간에 데이터를 기록하는 형식이 동일하게 됨으로써 데이터의 저장 및 활용이 용이하게 되었다. 마지막으로, 템플릿 정합된 데이터(파일 양식: PLY)는 저장 용량 측면에서 8,536명의 원본 3차원 머리 스캔 이미지들의 파일 용량은 총 29GB이지만, 본 연구를 통해 템플릿 정합된 머리 이미지들의 파일 용량은 1.86GB로 93.6% 감소되었다. 데이터의 크기가 작아짐에 따라 인체 측정 및 형상 분석 시 계산 속도가 빨라지게 되어 제품의 가상 착용(virtual fitting) 분석이나 형상 시각화 등의 계산에 용이할 수 있다(Lee et al., 2017a; Lee et al., 2020a).

개발된 한국인 머리 데이터베이스는 한국인에 대한 머리 치수 및 형상 분석, 제품의 가상 착의 분석, 제품 형상 설계 등에 유용하게 활용될 수 있다. 3차원 인체 측정은 3차원 인체 형상 상에 정의된 측정 참조점들을 기반으로 측정되는데, 본 연구의 43개의 측정 참조점들을 이용하면 기존 연구들에서 측정한 122개의 세부적인 얼굴 및 머리 관련 변수들을 측정할 수 있다. 또한, 기존에는 측정되지 않았지만 제품 설계와 관련도가 높은 세부적인 치수들이 측정 참조점들을 기반으로 필요에 따라 측정될 수 있다. 인체 형상 분석 측면에서는 템플릿 정합된 이미지들 간의 mesh 구조의 유사성을 기반으로 인체 형상의 변동성(variation)이 주성분 분석 등을 통해 분석에 활용될 수 있다(Figure 4). 구축된 데이터베이스는 한국인의 머리 크기 및 형상이 특성을 이해하는 데 유용하게 활용될 수 있을 것으로 기대된다. 한편, 본 연구의 사전 연구(Lee et al., 2020b)는 템플릿 정합된 2,300여 명의 미국인들의 머리에 제품을 가상 착의한 후, 유한요소 분석 기법을 이용하여 제품이 얼굴 부위에 가하는 접촉 압력(contact pressure)을 계산하는 방법을 제안하였고, 이를 산소 마스크 및 virtual reality (VR) 헤드셋 디자인의 평가에 활용하였다(Figure 5). 제안된 방법을 본 연구에서 개발된 한국인 머리 데이터베이스에 적용하면, 한국인의 머리에 밀착되는 제품들의 접촉 압력을 분석하고 이를 기반으로 한국인의 머리에 적합한 제품의 형상(들)을 탐색하기 위한 목적으로 활용될 수 있다. 그 외에도 한국인 머리의 템플릿 정합된 이미지 데이터베이스는 밀착성이 중요한 의료용 마스크 및 고글, 환자용 보철/보형물, 산업용 방진 마스크, 소방관용 및 군용 머리 보호장비, 보호용 고글, 그리고 운동선수의 기량을 증대시킬 수 있는 운동장비 등의 다양한 제품 설계에 필요한 인체 치수 및 형상을 분석하는 데 유용하게 활용될 수 있다. 본 연구에서 구축된 데이터베이스가 머리에 착용되는 제품의 인간공학적 설계 및 평가에 유용하게 활용될 수 있도록 하기 위해서는 머리의 치수 및 형상 분석, 제품의 가상 착의 및 제품 형상의 인체 적합성 분석, 제품의 최적 형상 설계 탐색 등을 간편하게 수행할 수 있는 시스템 구축이 요구된다(Lee et al., 2019).

템플릿 정합 방법의 효율성 향상을 위하여 deep learning 기술을 활용한 전자동 템플릿 이미지 정합 기술 방법이 요구된다. 본 연구는 원본 3차원 스캔된 얼굴 이미지에 11개의 초기 참조점을 수작업을 표시한 후 이를 이용하여 템플릿 이미지를 정합하였다. 한편, 최근 다양하게 연구되고 있는 convolutional neural network (CNN) 방법을 활용하면 얼굴 사진에서 눈동자, 코끝, 눈썹끝, 입술가장자리 등의 참조점들이 자동으로 파악될 수 있다(Fan and Zhou, 2016; He et al., 2017; Johnston and Chazal, 2018; Wu et al., 2018; Paulsen et al., 2019; Zhang et al., 2019; Kim et al., 2020). 하지만 기존 CNN에 활용된 사진들은 얼굴의 주요 부위들(예: 피부, 눈, 눈썹, 입술 등)의 색상 정보를 활용하여 참조점의 위치를 예측한다. 반면, 사이즈 코리아의 3차원 얼굴 스캔 이미지는 색상에 대한 정보가 부재하거나, 해상도가 낮아 얼굴의 부위(예: 눈 가장자리, 입술 가장자리)가 뚜렷하게 구분되지 않거나, 인체 표면의 품질이 좋지 않는 등(Figure 8)의 한계가 있어, 본 연구에서 시도한 바에 따르면 기존의 CNN 방법을 사이즈 코리아의 3차원 얼굴 스캔 이미지에 그대로 적용하기 어려웠다. 본 연구에서 제안한 하이브리드 템플릿 모델 정합 방법의 효율성을 제고하고 수작업의 노력을 최소화하기 위해서는 11개의 초기 참조점들을 자동으로 탐색하는 단계에 대한 연구가 필요하다.

마지막으로, 3차원 인체 스캔 이미지의 수집에 있어 스캔된 데이터의 품질뿐 아니라, 3차원 인체 스캔 대상자의 자세 및 표정에 관한 명확한 가이드 제공이 요구된다. 사이즈 코리아의 3차원 인체 스캔 이미지는 이미지의 해상도 및 컬러 정보의 유무 측면에서 품질이 좋지 않아 본 연구에서 제안된 템플릿 모델 정합을 통해 그 품질이 향상되었다. 템플릿 모델 정합은 수작업으로 표기하는 11개의 참조점을 기반으로 진행되는데, 원본 3차원 스캔 이미지의 품질이 좋지 않거나 컬러 정보가 부재하면 11개의 참조점을 표기하기에 어려움이 있다. 가령, 눈 가장자리나 입술 가장자리의 위치가 불명확하여 해당 참조점을 표기하기 어렵거나, 귀 주변에 스캔되지 않은 영역이 넓으면 귀구슬점을 표기할 수 없는 문제가 있었다. 향후 템플릿 모델 정합의 정확성 향상 및 템플릿 모델 정합 절차의 전자동화를 위해서는 원본 3차원 인체 스캔 이미지의 품질 제고가 요구된다. 한편, 다수의 사이즈 코리아의 머리 스캔 데이터에서 참여자들의 입술 모양이 자연스럽지 않고 입술 너비가 매우 좁거나 입술이 과도하게 비대칭이 것을 발견하였는데, 이는 참여자가 긴장함으로 인해 입술 부위에 힘을 주고 있기 때문인 것으로 판단된다. 3차원 인체 스캔 시 측정치 및 형상 분석의 정확도를 제공하기 위해서는 아래 항목을 포함한 명확한 가이드를 참여자에게 제공하여 참여자들의 머리 자세 및 표정을 통제할 필요가 있을 것으로 사료된다.

- 고개를 숙이거나 옆으로 기울이지 않고 정면을 바라볼 수 있도록 함.

- 치아, 턱, 입술, 그리고 눈에 힘이 과도하게 들어가지 않도록 얼굴 근육의 긴장을 풀도록 함.

- 눈동자점을 파악하기 위해 눈을 감지 않음.

- 귀구슬점을 파악하기 위해 귀구슬점 위치가 머리카락으로 덮이지 않도록 함.

본 연구는 사이즈 코리아의 3차원 얼굴 스캔 데이터의 활용도를 제고하기 위한 기반 연구로서 템플릿 모델 정합 기술을 이용하여 데이터의 품질을 향상시키고 참조점들을 표기하였다. 사이즈 코리아의 3차원 머리 스캔 데이터는 7~77세의 8,536명에 대한 광범위한 치수 및 형상 정보를 담고 있어 이는 한국인을 대상으로 한 머리 및 얼굴 착용 관련 제품에 유용하게 활용될 수 있다. 본 연구에서 구축된 데이터베이스는 추후 한국인의 얼굴에 대한 세부적인 치수 측정 및 분석, 치수체계 분석, 대표 머리 모델(representative head model) 개발, 형상의 다양성(shape variation) 분석, 가상 착의 분석, 제품의 대량 맞춤형 설계(mass-customized design) 등의 연구를 통해 다양한 제품의 개발에 활용될 수 있을 것으로 기대된다. 본 연구에서 구축된 데이터베이스는 추후 다양한 연구자 및 산업체 실무자들이 한국인의 머리 치수 및 형상 데이터를 효과적으로 분석 및 활용할 수 있도록 개발될 시스템을 통해 제공될 예정이다.

References

1. Ahn, Y. and Suh, M., A study on the head type of Korean women's for headgear pattern making, The Research Journal of the Costume Culture, 12(6), 1021-1030, 2004.

Google Scholar

2. Alexander, M., McConville, J.T. and Tebbetts, I., Anthropometric Sizing, Fit-Testing, and Evaluation of the MBU-12/P Oral-Nasal Oxygen Mask, AMRL-TR-79-44, Aerospace Medical Research Laboratory, Wright-Patterson Air Force Base, OH, 1979.

3. Allen, B., Curless, B. and Popović, Z., The space of human body shapes: reconstruction and parameterization from range scans, Acm Transactions on Graphics, 22(3), 587-594, 2003. doi:10.1145/882262.882311

4. Anguelov, D., Srinivasan, P., Koller, D., Thrun, S., Rodgers, J. and Davis, J., SCAPE: Shape completion and animation of people, Acm Transactions on Graphics, 24(3), 408-416, 2005. doi:10.1145/1073204.1073207

Google Scholar

5. Baek, S.Y. and Lee, K., Parametric human body shape modeling framework for human-centered product design, Computer-Aided Design, 44(1), 56-67, 2012. doi:10.1016/j.cad.2010.12.006

Google Scholar

6. Ball, R., Shu, C., Xi, P., Rioux, M., Luximon, Y. and Molenbroek, J.F.M., A comparison between Chinese and Caucasian head shapes, Applied Ergonomics, 41(6), 832-9, 2010. doi:10.1016/j.apergo.2010.02.002

Google Scholar

7. Ballester, A., Parrilla, E., Piérola, A., Uriel, J., Pérez, C., Piqueras, P., Nácher, B., Vivas, J.A. and Alemany, S., Data-driven three-dimensional reconstruction of human bodies using a mobile phone app, International Journal of the Digital Human, 1(4), 361-388, 2016. doi:10.1504/ijdh.2016.084581

Google Scholar

8. Ballester, A., Parrilla, E., Uriel, J., Pierola, A., Alemany, S., Nacher, B., Gonzalez, J. and Gonzalez, J.C., "3D-based resources fostering the analysis, use, and exploitataion of available body anthropometric data", Proceedings of 5th International Conference and Exhibition on 3D Body Scanning Technologies, Lugano, Switzerland, 2014.

Google Scholar

9. Besl, P.J. and McKay, N.D., A method for registration of 3-D shapes, IEEE Transactions on Pattern Analysis and Machine Intelligence, 14(2), 239-256, 1992. doi:10.1109/34.121791

10. Chu, C.H., Tsai, Y.T., Wang, C.C.L. and Kwok, T.H., Exemplar-based statistical model for semantic parametric design of human body, Computers in Industry, 61(6), 541-549, 2010. doi:10.1016/j.compind.2010.03.004

Google Scholar

11. Clauser, C., Tebbetts, I., Bradtmiller, B., McConville, J.T. and Gordon, C.C., Measurer's Handbook: U.S. Army Anthropometric Survey 1987-1988, NATICK/TR-88/043, U.S. Army Natick Research, Development and Engineering Center, Natick, MA, 1988.

12. Fan, H. and Zhou, E., Approaching human level facial landmark localization by deep learning, Image and Vision Computing, 47, 27-35, 2016. doi:10.1016/j.imavis.2015.11.004

Google Scholar

13. Gordon, C.C., Blackwell, C.L., Bradtmiller, B., Parham, J.L., Barrientos, P., Paquette, S.P., Corner, B.D., Carson, J.M., Venezia, J.C., Rockwell, B.M., Mucher, M. and Kristensen, S., 2012 Anthropometric Survey of U.S. Army Personnel: Methods and Summary Statistics, Natick/ TR-15/007, U.S. Army Natick Research, Development and Engineering Center, Natick, MA, 2014.

Google Scholar

14. Hack, A.L. and McConville, J.T., Respirator protection factors: Part I - Development of an anthropometric test panel, American Industrial Hygiene Association Journal, 39(12), 970-975, 1978.

Google Scholar

15. Han, D.H. and Choi, K.L., Facial dimensions and predictors of fit for half-mask respirators in Koreans, American Industrial Hygiene Association Journal, 64(6), 815-822, 2003.

Google Scholar

16. He, Z., Kan, M., Zhang, J., Chen, X. and Shan, S., A Fully End-to-End Cascaded CNN for Facial Landmark Detection. 2017 12th IEEE International Conference on Automatic Face & Gesture Recognition (FG 2017). 200-207, 2017.

Google Scholar

17. Hirshberg, D.A., Loper, M., Rachlin, E. and Black, M.J., Coregistration: simultaneous alignment and modeling of articulated 3d shape. 12th European conference on Computer Vision - Volume Part VI. Florence, Italy: Springer-Verlag, 242-255, 2012.

Google Scholar

18. Hughes, J.G. and Lomaev, O., An anthropometric survey of Australian male facial sizes, American Industrial Hygiene Association Journal, 33(2), 71-78, 1972.

Google Scholar

19. Jacobson, A., Baran, I., Popović, J. and Sorkine-Hornung, O., Bounded biharmonic weights for real-time deformation, Communications of the Acm, 57(4), 99-106, 2014. doi:10.1145/2578850

Google Scholar

20. Johnston, B. and Chazal, P.D., A review of image-based automatic facial landmark identification techniques, EURASIP Journal on Image and Video Processing, 2018(1), 2018. doi:10.1186/s13640-018-0324-4

Google Scholar

21. Kim, H.W., Kim, H.J., Rho, S. and Hwang, E., Augmented EMTCNN: A Fast and Accurate Facial Landmark Detection Network, Applied Sciences, 10(7), 2020. doi:10.3390/app10072253

Google Scholar

22. Kim, S., Analysis on the measurement and shape classification of the head and face for Korean female children aged 9~12 years, The Research Journal of the Costume Culture, 12(5), 757-768, 2004.

Google Scholar

23. Korean Agency for Technology and Standards (KATS), The Report on the 5th Size-Korea (Korean Body Measurement and Investigation), Size Korea, Ministry of Knowledge Economy, Seoul, Korea, 2004.

24. Korean Agency for Technology and Standards (KATS), The Report on the 6th Size-Korea (Korean Body Measurement and Investigation), Size Korea, Ministry of Knowledge Economy, Seoul, Korea, 2010.

25. Lee, W., Goto, L., Molenbroek, J.F.M. and Goossens, R.H.M., "Analysis methods of the variation of facial size and shape based on 3D face scan images", Proceedings of Human Factors and Ergonomics Society 61st Annual Meeting, Austin, TX, 2017a.

Google Scholar

26. Lee, W., Goto, L., Molenbroek, J.F.M., Goossens, R.H.M. and Wang, C.C.L., "A shape-based sizing system for facial mask design", Proceedings of 5th International Digital Human Modeling Symposium, Bonn, Germany, 2017b.

27. Lee, W., Jeong, J., Park, J., Jeon, E., Kim, H., Jung, D., Park, S. and You, H., Analysis of the facial measurements of Korean Air Force pilots for oxygen mask design, Ergonomics, 56(9), 1451-1464, 2013. doi:10.1080/00140139.2013.816376

Google Scholar

28. Lee, W., Jung, H. and You, H., "Application of 3D body scan data for ergonomic product design: Methods, research cases, and further study", Proceedings of 2019 Spring Conference of the Ergonomics Society of Korea, Jeju, Korea, 2019.

29. Lee, W., Jung, H. and You, H., Application of 3D human body template model for ergonomic product design, Journal of the Ergonomic Society of Korea, 39(3), 223-241, 2020a.

Google Scholar

30. Lee, W., Kim, J.G., Molenbroek, J.M.F., Goossens, R.H.M., Jung, H. and You, H., "Contact pressure analysis for wearable product design", Proceedings of 20th Congress of the International Ergonomics Association (IEA), (pp. 163-169), 2018a.

Google Scholar

31. Lee, W., Kim, J.G., Molenbroek, J.M.F., Goossens, R.H.M. and You, H., Estimation of facial contact pressure based on finite element analysis, In Advances in Additive Manufacturing, Modeling Systems and 3D Prototyping, 657-667, 2020b.

Google Scholar

32. Lee, W., Lee, B., Yang, X., Jung, H., Bok, I., Kim, C., Kwon, O. and You, H., A 3D anthropometric sizing analysis system based on North American CAESAR 3D scan data for design of head wearable products, Computers & Industrial Engineering, 117, 121-130, 2018b. doi:10.1016/j.cie.2018.01.023

Google Scholar

33. Lee, W., Yang, X., Jung, H., You, H., Goto, L., Molenbroek, J.F.M. and Goossens, R.H.M., Application of massive 3D head and facial scan datasets in ergonomic head-product design, International Journal of the Digital Human, 1(4), 344-360, 2016. doi:10.1504/ ijdh.2016.084592

Google Scholar

34. Li, P., Carson, J., Parham, J. and Paquette, S., "Digital human modeling pipeline with a 3D anthropometry database", Proceedings of 5th International Conference on Applied Human Factors and Ergonomics (AHFE), Los Angeles, CA, USA, 2017.

Google Scholar

35. Liang, S., Wu, J., Weinberg, S.M. and Shapiro, L.G., Improved detection of landmarks on 3D human face data, 35th Annual International Conference of the IEEE Engineering in Medicine and Biology Society (EMBC), 2013, 6482-6485, 2013. doi:10.1109/ EMBC.2013.6611039

Google Scholar

36. Luximon, Y., Ball, R. and Justice, L., "The Chinese face: A 3D anthropometric analysis", Proceedings of 8th International Symposium on Tools and Methods of Competitive Engineering (TMCE), Anncona, Italy, 2010.

Google Scholar

37. Luximon, Y., Ball, R. and Justice, L., The 3D Chinese head and face modeling, Computer-Aided Design, 44(1), 40-47, 2012.

Google Scholar

38. Luximon, Y., Ball, R.M. and Chow, E.H.C., A design and evaluation tool using 3D head templates, Computer-Aided Design and Applications, 13(2), 153-161, 2016. doi:10.1080/16864360.2015.1084188

Google Scholar

39. Oestenstad, R.K., Dillion, H.K. and Perkins, L.L., Distribution of faceseal leak sites on a half-mask respirator and their association with facial dimensions, American Industrial Hygiene Association Journal, 51(5), 285-290, 1990.

Google Scholar

40. Oh, Y. and Park, S., "The facial anthropometry with 3D head scanner for designing Korean gas mask", Proceedings of Society of CAD/CAM Engineers Conference, 2010.

41. Paulsen, R.R., Juhl, K.A., Haspang, T.M., Hansen, T., Ganz, M. and Einarsson, G., Multi-view Consensus CNN for 3D Facial Landmark Placement, In Computer Vision - ACCV 2018. 706-719, 2019.

Google Scholar

42. Robinette, K.M., Blackwell, S., Daanen, H., Boehmer, M., Fleming, S., Brill, T., Hoeferlin, D. and Burnsides, D., Civilian American and European Surface Anthropometry Resource (CAESAR) Final Report, Volume I: Summary, AFRL-HE-WP-TR-2002-0169, Human Effectiveness Directorate, Crew System Interface Division, Wright-Patterson Air Force Base, OH, 2002.

Google Scholar

43. Tsoli, A., Loper, M. and Black, M.J., "Model-based anthropometry: Predicting measurements from 3D human scans in multiple poses", Proceedings of IEEE Winter Conference on Applications of Computer Vision (WACV), 2014.

Google Scholar

44. Wu, Y., Hassner, T., Kim, K., Medioni, G. and Natarajan, P., Facial Landmark Detection with Tweaked Convolutional Neural Networks, IEEE Transactions on Pattern Analysis and Machine Intelligence, 40(12), 3067-3074, 2018. doi:10.1109/tpami.2017.2787130

Google Scholar

45. Xi, P. and Shu, C., Consistent parameterization and statistical analysis of human head scans, Visual Computer, 25(9), 863-871, 2009. doi:10.1007/s00371-009-0316-6

Google Scholar

46. Yang, Y., Yu, Y., Zhou, Y., Du, S., Davis, J. and Yang, R., "Semantic parametric reshaping of human body models", Proceedings of 2nd International Conference on 3D Vision, (pp. 41-48), Tokyo, Japan, 2014.

Google Scholar

47. Yokota, M., Head and facial anthropometry of mixed-race U.S. Army male soldiers for military design and sizing: A pilot study, Applied Ergonomics, 36(3), 379-383, 2005.

Google Scholar

48. Young, J.W., Head and Face Anthropometry of Adult U.S. Civilians, DOT/FAA/AM-93/10, U.S. Department of Transportation, Federal Aviation Administration, Office of Aviation Medicine, Washington, DC, 1993.

Google Scholar

49. Zhang, R., Mu, C., Xu, M., Xu, L. and Xu, X., Facial Component-Landmark Detection With Weakly-Supervised LR-CNN, IEEE Access, 7, 10263-10277, 2019. doi:10.1109/access.2018.2890573

Google Scholar

50. Zhuang, Z. and Bradtmiller, B., Head-and-face anthropometric survey of U.S. respirator users, Journal of Occupational and Environmental Hygiene, 2(11), 567-576, 2005.

Google Scholar

51. Zhuang, Z., Shu, C., Xi, P., Bergman, M. and Joseph, M., Head-and-face shape variations of U.S. civilian workers, Applied Ergonomics, 44(5), 775-784, 2013. doi:10.1016/j.apergo.2013.01.008

Google Scholar

PIDS App ServiceClick here!