eISSN: 2093-8462 http://jesk.or.kr

Open Access, Peer-reviewed

eISSN: 2093-8462 http://jesk.or.kr

Open Access, Peer-reviewed

Hyewon Yoon

, Gyewon Jeon

, Sangwon Lee

10.5143/JESK.2025.44.2.239 Epub 2025 May 06

Abstract

Objective: This study investigates the effects of explanation methods and users' risk-taking levels on trust, understanding, satisfaction, and investment behavior in AI-based investment chatbots.

Background: AI-driven financial services increasingly require transparent explanations to build user trust and satisfaction. However, most explanation methods overlook user characteristics. This study examines how risk-taking levels impact users' perceptions and behaviors of AI explanations.

Method: A 3 (explanation methods: factual, counterfactual, combined) × 2 (risk-taking levels: high, low) between-subject experiment was conducted using an AI chatbot developed with XGBoost and SHAP for explanations. 115 participants interacted with the chatbot in a P2P lending scenario. Trust, understanding, satisfaction, and investment amounts were measured.

Results: Risk-taking levels significantly influenced trust, satisfaction, and investment amounts, while explanation methods affected understanding. High risk-takers showed higher satisfaction with factual explanations, despite lower understanding. Self-reported AI knowledge positively correlated with trust with AI results.

Conclusion: Personalized explanation methods tailored to users' risk-taking levels and AI backgrounds enhance decision-making in AI-driven financial systems.

Application: These findings guide the development of adaptive AI chatbots that personalize explanations, improving user experience and decision-making in real-world financial contexts.

Keywords

Explanation User characteristics Fintech Chatbot eXplainable AI

금융 분야에서 인공지능(Artificial Intelligence, AI)은 실시간 데이터 처리 능력에 기반한 신속한 의사결정과 효율적인 업무 자동화를 지원하며, 로보 어드바이저, 의사결정 지원 시스템, 트레이딩 등 다양한 영역에서 활용되어 지속적으로 주목을 받아왔다. 이러한 AI 기술의 도입은 개인 투자자부터 금융 기관을 포함한 다양한 이해관계자의 업무 효율성을 향상시키는 데 기여한다. 그러나 AI는 복잡한 기계 학습 모델과 대규모 데이터 기반으로 의사결정을 내리기 때문에 그 과정이 사용자에게 불투명하게 전달된다. 이로 인해 사용자는 AI의 판단 근거를 이해하거나 검증하기 어려워져 시스템에 대한 신뢰성이 저하되는 'Black box' 문제가 발생할 수 있다(Rai, 2020). 특히, AI 시스템이 내린 결과의 근거와 과정이 설명되지 않을 때 사용자는 시스템에 대한 신뢰를 잃게 되며, 이는 궁극적으로 사용자의 의사결정 과정 및 결과에 부정적인 영향을 초래할 수 있다(Pedreschi et al., 2019). 이와 관련하여 유럽 연합의 일반 개인정보보호법(General Data Protection Regulation, GDPR)은 "자동화된 의사결정의 존재와 해당 의사결정에 포함된 논리에 대한 의미 있는 정보"의 제공을 명시하고 있다(Regulation, 2016). 이는 AI 시스템이 단순히 결과만 제공하는 것을 넘어 그 과정과 근거를 투명하게 설명해야 함을 의미한다. 이러한 법적 · 사회적 요구는 AI 시스템이 제공하는 설명의 필요성을 더욱 부각시키며, AI 기반 시스템의 설명 설계의 기준으로 고려되어야 한다.

AI가 생성한 결과에 대한 설명 방식은 다양한 관점에서 논의되어 왔으며, 텍스트 기반 설명과 시각적 설명의 효과를 비교하는 연구도 활발히 진행되고 있다. 예를 들어, 텍스트 기반 설명이 시각적 설명에 비해 사용자로부터 더 높은 설득력을 얻는 것으로 보고된 바 있다(Kouki et al., 2019). 더 나아가, 텍스트 기반 설명의 효과를 높이기 위해 시각적 설명을 결합하여 만족도를 측정하거나(Chatti et al., 2022), 텍스트 기반 설명의 내용에 차이를 두어 효과성을 비교하는 연구(Hernandez-Bocanegra et al., 2020)가 수행되어 왔다. 한편, Szymanski et al. (2021)는 전문가 사용자에게 시각적 설명은 텍스트 기반 설명보다 더 빠르고 효율적인 정보 제공 방식으로 작용한다고 보고했다. 그러나 비전문가 사용자의 경우, 시각적 설명보다 텍스트 기반 설명을 제공받았을 때 과업 수행 정확도가 유의미하게 높게 나타나는 경향이 관찰되었다. 이러한 차이는 사용자의 도메인 전문성 수준에 기인하는 것으로 해석될 수 있다.

한편, AI 모델의 작동 원리와 예측 결과를 효과적으로 설명하기 위해 특성 중요도(Ribeiro et al., 2016; Bove et al., 2022), 반사실적 설명(Mothilal et al., 2020; Bove et al., 2023), 규칙 기반 설명(Ribeiro et al., 2018) 등 다양한 접근 방식이 제안되어 왔다. 특히, 사실적 설명과 반사실적 설명을 결합하여 제공할 때 시스템에 대한 신뢰도가 향상된다는 연구가 보고된 바 있다(Schoeffer et al., 2022). 그러나 일부 연구는 설명 방법에 따른 효과 차이가 없다고 보고했으며, 이러한 상반된 결과는 사용자 특성의 차이에서 기인할 가능성이 있다. 즉, 동일한 설명 방식이라도 사용자에 따라 다르게 해석되고 수용되며, 그 효과 역시 달라질 수 있다. 이는 사용자의 개인적 특성이 AI의 설명을 어떻게 인식하고 받아들이는지에 유의미한 영향을 미치기 때문이다(Kouki et al., 2019; Alslaity and Tran, 2020; Szymanski et al., 2021; Ehsan et al., 2024). AI의 결과에 대한 설명 방법에 대한 연구들은 AI 모델에 대한 이해도를 높이고, AI 기반 시스템에 대한 사용자 경험을 향상하는 데 기여했다. 그러나 모든 사용자에게 동일한 설명을 제공하는 'one-size-fits-all' 방식으로 제공되어 사용자 개인의 다양성을 충분히 고려하지 못한다는 한계가 존재한다.

따라서, AI 시스템에서 제공하는 설명은 사용자 개인의 특성을 고려해 설계되어야 한다. 설명의 효과는 사용자에 개인의 특성에 따라 달라지며, 이는 궁극적으로 AI 기반 시스템에 대한 사용자의 신뢰 형성에 영향을 미치기 때문이다(Li et al., 2024). 특히 개인 특성에 부합하는 맞춤형 설명은 사용자의 이해도와 만족도를 높이는 동시에 AI 시스템에 대한 신뢰도를 증진시킬 수 있다. 이러한 측면에서 AI가 제공하는 설명은 단순한 정보 전달을 넘어, 사용자 경험을 향상시키기 위해 개인화된 접근 방식으로 제공되어야 한다(Mubaraq et al., 2021). 이는 금융 의사결정과 같은 고위험 맥락에서 더욱 중요하며, 위험 감수 성향과 같은 개인 특성을 반영한 설명 방식이 사용자의 의사결정 효과성과 AI 시스템의 활용도를 높이는 데 기여할 수 있다. 실제로, 금융 의사결정과 같은 맥락에서는 개인의 특성이 투자 행동과 결과에 직접적인 영향을 미치는 것으로 보고되고 있다.

금융 의사결정에서 사용자 개인의 성격 특성은 투자 행동에 유의미한 영향을 끼친다. 예를 들어, 'Big Five' 성격 특성 중 일부 요소는 투자 의사결정(Meman and Chouhan, 2021), 금융 만족도(Sachdeva and Lehal, 2023), 가계비와 관련된 의사결정(Brown and Taylor, 2014)에 영향을 끼친다는 보고가 있다. 이러한 연구들은 개인의 성격이 투자 행동의 다양성을 설명할 수 있음을 시사한다. 특히, 위험 감수 성향은 투자 행동에 유의미한 영향을 끼치기 때문에 금융 분야에서 중요한 특성으로 간주되고 있다(Ainia and Lutfi, 2019). 예를 들어, Mubaraq et al. (2021)은 금융 지식과 위험 감수 성향을 고려한 개인화 전략이 투자 성과와 만족도를 크게 향상시킬 수 있음을 보고했다. 반면에 Dikmen and Burns (2022)는 사용자 위험 감수 성향에 따른 투자 금액 차이를 비교했으나 유의미한 차이가 보고되지 않았다. 이러한 차이는 투자 의사결정 과정에서 제공된 설명이 사용자 특성을 충분히 반영하지 않았기 때문에 나타난 결과일 수 있다. 이를 위해서는 AI가 제공하는 설명 방법과 사용자 특성 간의 상호작용을 체계적으로 분석하는 연구가 필요하다. 이에 본 연구에서는 위험 감수 성향에 주목하여, 설명 방법의 차이가 사용자 경험과 의사결정에 미치는 영향을 실증적으로 검증함으로써 효과적인 설명 방법을 도출하고자 한다.

본 연구는 기존 웹 기반 금융 의사결정 지원 인터페이스(Dikmen and Burns, 2022)와 다르게 대화형 의사결정 지원 시스템과의 상호작용을 통한 투자 상황에서 얻을 수 있는 차별적 시사점을 도출하고자 하였다. 이를 위해 Peer-to-Peer (P2P) 대출 시나리오 기반의 금융 의사결정 맥락에서 AI 기반 챗봇이 제공하는 설명 방법의 효과가 사용자 위험 감수 성향에 따라 어떻게 달라지는지 실증적으로 분석하였다. P2P 대출은 온라인 플랫폼을 통해 개인이 다른 개인이나 기업에게 자금을 대출해주는 금융 서비스로, 투자자는 대출 신청자의 신용도 · 대출 목적 · 이자율 등을 종합적으로 평가하여 투자 여부를 결정한다(Oxera, 2016). P2P 대출은 차입자가 자신의 정보를 제공하고 대출을 신청하면, 투자자는 대출을 제안하거나 요청된 대출에 자금을 제공할 수 있다. 투자자는 차입자가 대출금을 상환함에 따라 이자를 얻는다(Bachmann et al., 2011). 본 연구의 AI 기반 금융 의사결정 챗봇은 P2P 대출에서 투자 가치가 높은 차입자를 추천하며, GDPR에서 요구하는 설명 기준을 충족하도록 사실적 설명과 반사실적 설명을 통해 그 평가 근거를 투명하게 제공한다. 사실적 설명은 AI가 고려한 요인과 그 중요도를 명시하여 의사결정 과정을 투명하게 보여주고, 반사실적 설명은 입력 값이 달라졌을 때 결과가 어떻게 변할 수 있는지를 제시함으로써 인과 관계에 대한 이해를 돕는다. 이러한 설명 방법들이 AI가 도출한 결과에 끼치는 영향을 분석하고, 위험 감수 성향별 적합한 설명 방식을 도출하였다. 또한, 주관적인 AI 지식수준, 투자 기간 등 다른 사용자 특성이 금융 의사결정 및 AI 기반 시스템에 끼치는 영향을 확인하여 사용자 개별 특성에 맞춘 설명 방식을 제안하였다. 이는 금융 의사결정을 위한 개인화 시스템 설계에 실질적인 인사이트를 제공하여 보다 효과적인 상호작용과 의사결정을 지원할 수 있을 것이다. 도출된 인사이트는 금융 분야에서 의사결정 시스템뿐만 아니라, 보험, 헬스케어와 같이 사용자 맞춤형 AI 의사결정 지원 시스템 개발이 요구되는 다양한 산업 분야의 AI 기반 서비스 설계 시 활용될 수 있을 것으로 기대된다.

Schoeffer et al. (2022)는 자동 대출 승인 시스템에서 제공되는 정보의 유형이 사용자의 신뢰도에 미치는 영향을 실험적으로 탐구했다. 연구에서는 설명이 없는 기본 조건을 시작으로, 요인 중요도를 포함한 사실적 설명, 그리고 반사실적 설명을 점진적으로 추가하며 사용자의 반응을 분석했다. 그 결과, 사실적 설명과 반사실적 설명을 단일 형태로 제공할 때보다 두 가지를 결합하여 제공했을 때 자동 대출 승인 시스템에 대한 신뢰도가 향상되었다. 이는 결합형 설명이 단일 설명보다 사용자의 신뢰도를 높이는 데 효과적일 수 있음을 보여준다. 또한, Hsiao et al. (2021)에 따르면, 신뢰도가 높아질수록 사용자의 이해도와 만족도 역시 증가하는 경향이 관찰되었다. 이는 신뢰도 향상이 다른 사용자 반응의 향상으로 이어질 수 있음을 시사한다. 이러한 선행 연구를 바탕으로, 설명의 유형(사실적 설명, 반사실적 설명, 결합형 설명)이 AI 시스템에 대한 사용자의 반응과 행동에 미치는 영향을 체계적으로 검토할 필요가 있다. 그러나 기존 연구는 주로 자동화된 대출 승인 시스템에 초점을 맞춘 반면, 본 연구에서는 투자 의사결정을 지원하는 챗봇에 주목한다. 특히, 챗봇의 지속적인 상호작용을 통해 사용자가 투자 관련 정보를 실시간으로 받아들이고 반응하는 과정을 중심으로, 사실적 설명과 반사실적 설명을 함께 제공하는 결합형 설명과 단일 설명을 비교하여 설명 방법이 사용자 반응과 행동에 미치는 영향을 검증하고자 한다. 이를 위해 다음과 같은 가설을 제시한다.

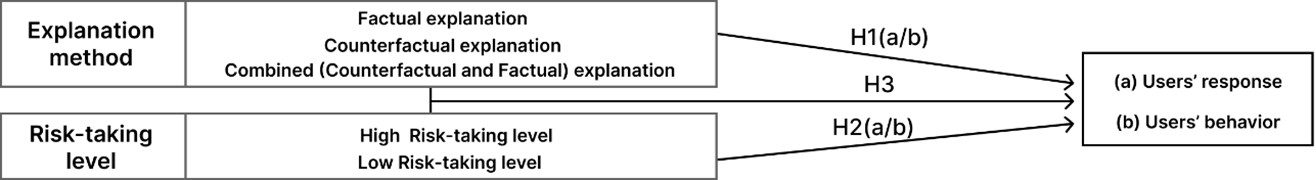

H1(a): 결합형 설명(사실적 설명과 반사실적 설명) 제공은 단일 설명(사실적 설명, 반사실적 설명) 제공에 비해 AI의 결과에 대한 사용자 반응(신뢰, 이해도, 만족도)을 증가시킬 것이다.

H1(b): 결합형 설명(사실적 설명과 반사실적 설명) 제공은 단일 설명(사실적 설명, 반사실적 설명) 제공에 비해 AI의 결과에 대한 사용자 행동(투자 금액)을 증가시킬 것이다.

위험 감수 성향은 사용자의 인식과 행동에 중요한 영향을 미칠 수 있다. Wu and Chang (2007)은 온라인 쇼핑 맥락에서 고객의 위험 감수 성향이 만족도와 재구매 의도에 미치는 영향을 조사했으며, 위험 감수 성향이 낮은 고객일수록 만족도가 더 높게 나타난다는 점을 밝혀냈다. 또한, 금융 리스크 태도에 따라 금융 만족도 수준이 달라질 수 있다(Saurabh and Nandan, 2018). 이들은 개인의 위험에 대한 태도가 의사결정 결과에 영향을 미친다고 보았다. 투자와 같은 금융 의사결정에서 위험 감수 성향이 핵심적인 역할을 한다. 특히, 기존 웹 형태의 인터페이스에서 투자 행동은 위험 감수 성향에 따라 다르게 나타날 수 있다(Keller and Siegrist, 2006; Hyll and Irrek, 2015). 이러한 선행 연구들은 위험 감수 성향이 사용자의 인식과 행동에 미치는 영향을 일관되게 시사한다. 그러나 챗봇 형태의 지속적인 상호작용을 기반으로 한 상황에서 위험 감수 성향이 사용자의 인식과 행동에 미치는 영향에 대한 연구는 상대적으로 부족한 실정이다. 따라서, 본 연구에서는 위험 감수 성향(높음, 낮음)에 따라 AI 기반 금융 의사결정 챗봇의 결과에 대한 사용자의 반응과 행동이 다르게 나타나는지 탐구하고자 한다. 이를 바탕으로 다음과 같은 가설을 제시한다.

H2(a): AI의 결과에 대한 사용자 반응(신뢰, 이해도, 만족도)은 위험 감수 성향(높음, 낮음)에 따라 차이를 보일 것이다.

H2(b): AI의 결과에 대한 사용자 행동(투자 금액)은 위험 감수 성향(높음, 낮음)에 따라 차이를 보일 것이다.

설명 방법의 효과는 사용자 특성에 따라 다르게 나타날 수 있다(Alslaity and Tran, 2020). 특히 위험 감수 성향은 사용자가 정보를 받아들이고 반응하는 방식에 중요한 영향을 미칠 수 있으며, 이에 맞춘 맞춤형 설명 제공은 사용자 경험을 유의미하게 향상시킬 가능성이 있다. 기존 연구에서는 주로 위험 감수 성향이 투자 상품 선택(Bertrand et al., 2023)이나 투자 금액(Dikmen and Burns, 2022)에 미치는 영향을 다루었으나, 설명 방법과 위험 감수 성향 간의 상호작용 효과에 대한 탐구는 상대적으로 부족하다.

Schoeffer et al. (2022)에 따르면, 사실적 설명과 반사실적 설명을 결합하여 제공하면 AI가 내린 결정에 대해 더 긍정적인 반응을 보이고, 보다 적극적인 행동을 보일 가능성이 크다. 또한, 위험 감수 성향이 높은 사용자가 추가적인 정보를 보다 가치 있게 인식하는 경향이 보고되었다(Treich, 1997). 이러한 결과는 설명 방법(사실적 설명, 반사실적 설명, 결합형 설명)이 위험 감수 성향(높음, 낮음)에 따라 사용자 반응과 행동에 차별적인 영향을 미칠 수 있음을 시사한다. 예를 들어, 위험 감수 성향이 높은 사용자는 결합형 설명을 받았을 때 AI의 결과에 대해 더 긍정적으로 반응할 가능성이 크다.

따라서 본 연구에서는 이 두 변수 간의 상호작용이 AI의 결과에 대한 사용자 반응과 행동에 어떻게 영향을 미치는지를 검증하고자 한다. 이는 설명 방식의 효과를 최적화하고 사용자 특성에 맞춘 AI 설계를 이해하는 데 중요한 시사점을 제공할 것이다. 이를 바탕으로 다음과 같은 가설을 제시한다.

H3: 설명 방법과 위험 감수 성향 간에는 상호작용 효과가 존재할 것이다.

이러한 선행 연구 결과를 바탕으로 본 연구에서는 AI 기반한 챗봇을 활용한 금융 투자 의사결정 상황에서 위험 감수 성향을 고려한 설명 방법의 차이를 비교하기 위한 가설을 설정하였다. 연구모형과 가설은 Figure 1에 제시되어 있다.

3.1 Investment AI chatbot interface

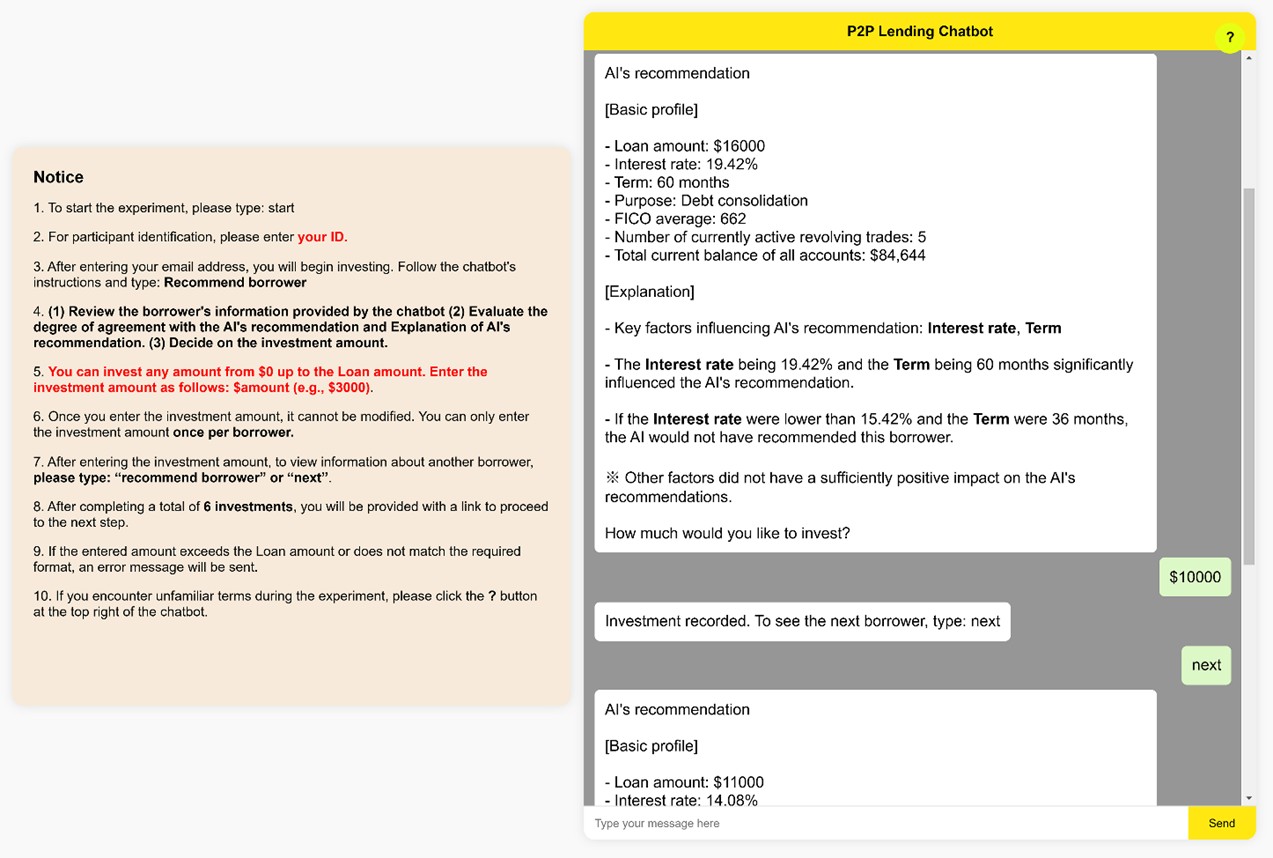

실험용 챗봇 인터페이스는 Python과 HTML을 활용하여 개발되었으며, Amazon Web Services (AWS)를 통해 배포되었다. 참가자들은 챗봇을 통해 AI가 생성한 투자 결정을 확인한 후, 본인이 결정한 투자 금액을 입력하였다. 챗봇 인터페이스는 실제 투자 결정을 내리는 과정을 반영하도록 설계되었으며, 사용자는 각 차입자에 대한 정보를 검토한 뒤 챗봇에 입력하여 투자 결정을 내렸다.

Figure 2는 실험에 사용된 챗봇 프로토타입이다. 왼쪽에 위치한 notice에는 참가자들이 챗봇과 상호작용하는 방법에 대한 가이드라인이 제시되어 있으며, 오른쪽에는 주요 과업 수행을 위해 개발된 챗봇이 있다. 챗봇 상단의 '?' 아이콘을 클릭하면 실험에 사용된 금융 용어에 대한 설명을 확인할 수 있다. 챗봇이 제공하는 설명에는 AI가 추천한 차입자에 대한 정보를 제공한다. 먼저, 차입자의 기본 프로필을 제시한 후, AI의 추천에 영향을 미친 주요 요인을 설명한다. 또한, AI의 추천에 유의미한 영향을 미치지 않은 다른 요인들도 함께 제공된다.

3.2 Participants

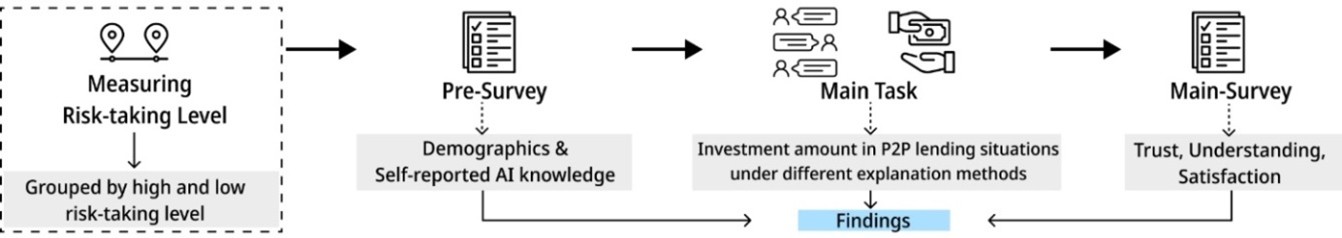

본 연구는 크라우드 소싱 플랫폼인 CloudResearch를 통해 120명의 참가자를 모집하였다. 실험이 영어로 진행되었으며, AI가 내린 결정에 대한 설명의 효과를 측정하고자 하는 연구 목적에 따라 영어를 모국어로 사용하며 영어 문장을 이해할 수 있는 성인을 1차 선별 기준으로 삼았다. P2P 대출은 일반인 사용자 대상으로 서비스되며 본 연구 역시 사용자의 금융 배경 지식이나 전문성을 전제하지 않고 일반인 사용자를 대상으로 설계되었다. 위험 감수 성향에 따른 설명 방법의 효과를 탐구하는 연구 목표를 충족하기 위해 Weber et al. (2013)에서 사용된 위험 감수 성향 측정을 위한 사전 설문을 실시했다. 이에 따라, 기준에 해당하는 참가자만 본 실험에 참여할 수 있도록 웹 페이지 링크를 제공받았다. 참여에 대한 보상으로 15분간 참여 시 2달러를 지급하였다. 주의력 확인 문항에 부적절하게 응답한 5명의 데이터를 제외하고, 총 115명의 데이터를 최종 분석에 사용하였다. 위험 감수 성향에 따라 고위험 감수 집단(57명)과 저위험 감수 집단(58명)으로 구분하였다. 참가자의 평균 연령은 37.3세(SD = 11)였으며, 성별 분포는 남성 66명(57.4%), 여성 48명(41.7%), 기타로 응답한 참가자 1명(1%)이었다.

3.3 Experimental procedure

Figure 3은 본 실험의 전체 과정을 나타낸다. 위험 감수 성향에 따른 뚜렷한 차이를 관찰하기 위해, 중간 수준의 위험 감수 성향을 가진 참가자는 제외하였다. 참가자들은 고위험 감수 집단과 저위험 감수 집단으로 분류되어 실험에 참여하였다. 실험 참여 전, 참가자들은 온라인 동의서를 제출하였으며, 이후 사전 설문을 통해 인구통계 정보, 투자 경험, 그리고 AI에 대한 사전 지식을 수집하였다. 이 과정에서 참가자들은 실험의 목적과 절차에 대한 설명을 제공받았다. 또한, P2P 대출에 대해 익숙하지 않은 참가자들을 위해 P2P 대출에 대한 정의와 개념이 소개되었다. 그리고 'Loan amount', 'Interest rate', 'FICO average', 'Total current balance of accounts', 'Number of currently active revolving trades'와 같은 P2P 대출 관련 용어에 대한 설명과 예시도 함께 제시되었다.

주요 과업으로 참가자들은 P2P 대출 시나리오에서 투자자로서 역할을 수행하여 챗봇에서 제공되는 차입자들이 AI에 의해 추천된 이유에 대한 설명을 읽고 투자 금액을 결정했다. P2P 대출은 차입자와 투자자를 직접 연결해주는 서비스로서, 참가자들은 투자자의 역할을 맡았다. 챗봇에 접속하여 참가자들은 채팅을 통해 챗봇과 상호작용하며 각 차입자에 대한 AI의 결과에 대한 설명을 제공받았다. 모든 참가자들은 총 6명의 차입자에 대한 정보와 설명을 순차적으로 검토하고 결정한 투자 금액을 챗봇에 입력했다. 참가자들은 0달러부터 차입자들이 대출받고자 하는 금액까지 자유롭게 투자를 결정할 수 있도록 설계되었다. 예를 들어, $23,000를 대출받고자 하는 차입자에게는 $0부터 $23,000까지의 범위에서 투자를 할 수 있다. 모든 참가자들은 동일하게 제공되는 6명의 차입자에 대한 정보와 설명을 검토한 후, 투자 결정을 내린 결과를 챗봇 인터페이스에 직접 입력했다. 각 차입자에 대한 결정이 입력되면 챗봇은 자동으로 다음 차입자 정보를 제공하였으며, 총 6번의 상호작용이 완료되면 설문조사 링크가 제공되어 후속 평가가 진행되었다.

3.4 Experimental setup

본 연구는 3(설명 방법) × 2(위험 감수 성향)의 피험자 간 설계를 통해 총 6개의 실험 조건을 구성했다. 이를 통해 AI 결정에 대한 설명 방식의 효과가 위험 감수 성향에 따라 어떻게 달라지는지를 규명하고자 한다. 설명 방법으로는 사실적 설명, 반사실적 설명, 결합형 설명이 사용되었다. 위험 감수 성향은 Weber et al. (2013)에서 사용된 3문항 척도를 통해 5점 리커트 척도로 측정되었으며, 이를 기준으로 고위험 감수 집단과 저위험 감수 집단으로 구분하였다. 3점부터 7점은 저위험 감수 집단으로 구분되었고, 11점부터 15점은 고위험 감수 집단으로 구분되었다. 위험 감수 성향 간 명확한 차이를 확인하기 위해 8점부터 10점은 중간 집단으로 구분되어 실험에서 제외되었다.

사실적 설명은 특정 결정을 내린 이유를 설명하며, Shapley 값이 0.2 이상인 주요 특성을 기반으로 제공되었다. 예를 들어, "The loan amount being $29,000 significantly influenced the AI's recommendation."라는 설명이 제공되었다. 반사실적 설명은 의사결정 결과에 영향을 미칠 수 있는 요인의 조건이 변경되는 상황을 가정하여 결과를 설명한다. 예를 들어, "If the loan amount were lower than $23,000, the AI would not have recommended this."라는 설명을 제공하였다. 결합형 설명은 사실적 설명과 반사실적 설명을 함께 제공하여 사용자의 이해를 돕도록 설계되었다. 참가자들은 사실적 설명, 반사실적 설명, 결합형 설명 중 랜덤하게 한 조건에 배정되었다.

3.5 Measures

개인화된 설명을 제공하는 것은 사용자가 금융 의사결정을 보다 잘 이해하고 AI의 결과에 대한 신뢰를 형성하는 데 필수적이다. 또한, 설명 방법의 효과를 평가할 때에는 사용자의 이해도와 만족도를 함께 측정해야 한다. 이에 따라 본 연구에서는 AI의 결과에 대한 신뢰도, 이해도, 그리고 만족도가 측정되었다. 신뢰 및 만족도는 Hoffman et al. (2018)에서 사용된 6문항을 기반으로 7점 리커트 척도를 통해 측정되었다. 이해도는 Guo et al. (2022)에서 사용된 8문항을 활용하여 7점 리커트 척도로 측정되었다. 본 연구를 통해 도출된 결과는 위험 감수 성향에 따른 설명 방법의 효과를 분석함으로써, 사용자의 투자 결정 지원을 위한 AI 시스템 설계에 실질적인 인사이트를 제공할 것으로 기대된다.

Table 1은 신뢰도, 이해도, 만족도, 그리고 투자 금액에 대한 기본 통계량을 요약하여 제시한다. 본 표는 설명 방법과 위험 감수 성향의 다양한 조합이 종속 변수에 미치는 영향을 보여준다. 이원 분산 분석을 실시하기 전에 Shapiro-Wilk 검정을 사용하여 각 변수의 데이터가 정규성을 따르는 지 확인했다(신뢰도의 경우 p = 0.56), (이해도의 경우 p = 0.134), (만족도의 경우 p = 0.135), (투자 금액의 경우 p = 0.051). 분산의 동질성을 확인하기 위해 Levene의 검정을 사용했다(신뢰도의 경우 p = 0.077), (이해도의 경우 p = 0.862), (만족도의 경우 p = 0.137), (투자 금액의 경우 p = 0.852). 가설을 검증하기 위해 신뢰도, 이해도, 만족도, 투자 금액을 종속 변수로 하여 3(설명 방법) × 2(위험 감수 성향)의 이원 분산분석을 실시하였다. 그 결과는 Table 2에 제시하였다.

|

Explanation |

Risk-taking |

Trust |

Understanding |

Satisfaction |

Investment

amount |

|

Factual |

High |

4.85 (1.1) |

5.54 (1.08) |

5.08 (0.404) |

61,657 (20,179) |

|

Low |

4.08 (0.768) |

4.53 (0.929) |

4.67 (0.275) |

57,046 (26,332) |

|

|

Counterfactual |

High |

4.68 (0.587) |

3.06 (0.748) |

5.08 (0.439) |

65,883 (23,299) |

|

Low |

4.27 (0.757) |

4.60 (0.917) |

4.76 (0.286) |

55,193 (24,631) |

|

|

Combined |

High |

4.37 (0.952) |

5.10 (0.907) |

4.97 (0.356) |

67,900 (20,266) |

|

Low |

4.18 (0.806) |

5.10 (0.91) |

4.96 (0.37) |

53,142 (25,789) |

|

|

Main effect of |

Main effect of |

Interaction |

||||||

|

F(2, 109) |

p |

|

F(1, 109) |

p |

|

F(2, 109) |

p |

|

|

|

Trust |

0.676 |

0.511 |

0.012 |

8.273 |

0.005** |

0.071 |

1.133 |

0.326 |

0.02 |

|

Understanding |

23.34 |

< .001*** |

0.3 |

1.05 |

0.308 |

0.01 |

18.45 |

< .001*** |

0.253 |

|

Satisfaction |

0.576 |

0.564 |

0.01 |

13.59 |

< .001*** |

0.111 |

3.302 |

0.041* |

0.057 |

|

Investment amount |

0.0315 |

0.969 |

0.001 |

5.2054 |

0.024* |

0.046 |

0.4462 |

0.641 |

0.008 |

|

*p<.05, **p<.01,

***p<.001 |

|||||||||

4.1 Explanation methods

설명 방법의 주 효과를 확인하기 위한 ANOVA 분석 결과, 이해도에 대해 통계적으로 유의미한 주 효과가 나타났다. 구체적으로, 결합형 설명 조건에서의 이해도(M = 5.1, SD = 0.896)가 반사실적 설명 조건(M = 3.88, SD = 1.14)보다 높게 나타났으며, 사실적 설명 조건(M = 5.05, SD = 1.12)에서도 반사실적 설명보다 높은 이해도를 보였다. 그러나, 설명 방법에 따른 신뢰도, 만족도, 그리고 투자 금액에서는 통계적으로 유의미한 차이가 나타나지 않았다.

4.2 Risk-taking levels

위험 감수 성향의 주 효과를 분석한 결과, 신뢰도와 만족도에서 유의미한 차이가 확인되었다. 위험 감수 성향이 높은 집단이 낮은 집단에 비해 신뢰도와 만족도가 더 높은 것으로 나타났다. 반면, 이해도에 대해서는 위험 감수 성향에 따른 유의미한 차이가 없었다. 투자 금액(미국 달러 기준)에서는 위험 감수 성향의 주 효과가 유의미하게 나타났으며, 고위험 감수 집단(M = 65,182, SD = 21,025)의 평균 투자 금액이 저위험 감수 집단(M = 55,096, SD = 25,143)보다 유의하게 높았다.

4.3 Interaction effects

설명 방법과 위험 감수 성향 간의 상호작용 효과를 분석한 결과, 이해도와 만족도에서 유의미한 상호작용 효과가 확인되었다. 사후 검정 결과, 위험 감수 성향이 높은 집단에서 결합형 설명의 이해도가 반사실적 설명보다 유의하게 높았다(p < .001). 또한, 동일한 고위험 감수 성향 집단에서 사실적 설명 역시 반사실적 설명보다 유의미하게 높은 이해도를 보였다(p < .001). 설명 방법에 따른 위험 감수 성향의 차이를 살펴본 결과, 사실적 설명 조건에서는 고위험 감수 성향 집단이 저위험 감수 성향 집단보다 더 높은 이해도를 보였으며(p = 0.015), 반사실적 설명 조건에서는 저위험 감수 성향 집단이 고위험 감수 성향 집단보다 높은 이해도를 보였다(p < .001).

만족도에 있어서도 설명 방법과 위험 감수 성향 간의 상호작용 효과가 유의미하게 나타났다. 사실적 설명 조건에서는 고위험 감수 성향 집단의 만족도가 저위험 감수 성향 집단보다 높았으며(p = 0.011), 특히 고위험 감수 성향 집단에 반사실적 설명을 제공했을 때, 저위험 감수 성향 집단에 사실적 설명을 제공한 경우보다 만족도가 유의하게 높았다(p = 0.011). 반면, 설명 방법과 위험 감수 성향 간의 상호작용 효과는 신뢰도와 사용자 행동에서는 통계적으로 유의미한 차이를 보이지 않았다.

본 연구의 가설 검증 결과는 Table 3에 제시되어 있다. 가설 1에 대한 분석 결과, 설명 방법에 따라 유의미한 차이는 이해도에서만 확인되었다. 가설 2는 신뢰도, 만족도, 그리고 투자 금액에서 유의미한 차이가 확인되어 지지되었으나, 이해도에서는 유의미한 차이가 나타나지 않아 부분적으로 지지되었다. 가설 3은 이해도와 만족도에서 부분적으로 지지되었으며, 신뢰도와 사용자 행동에서는 유의미한 차이가 확인되지 않았다. 이러한 결과에 대한 해석은 5.1절에서 논의하며, 기각된 가설에 대한 추가 분석은 5.2절에서 제시하여 본 연구의 시사점을 확장하였다.

|

Hypotheses |

|||

|

Result |

H1 |

H2 |

H3 |

|

Trust |

✘ |

✔ |

✘ |

|

Understanding |

Δ |

✘ |

✔ |

|

Satisfaction |

✘ |

✔ |

✔ |

|

Investment amount |

✘ |

✔ |

✘ |

|

✘ indicates that the hypotheses are not supported; Δ indicates that the

hypotheses are partially supported; ✔ indicates that

the hypotheses are fully supported |

|||

5.1 Effects of explanation methods and risk-taking levels in investment AI chatbot

AI 기반 투자 챗봇은 사용자의 위험 감수 성향을 사전에 파악하고, 이에 맞춘 차별화된 설명 방법을 제공해야 한다. 이를 위해 초기에 투자자의 위험 감수 성향을 확인할 수 있는 질문을 통해 정보를 수집하고, 그에 적합한 설명 방식을 적용할 필요가 있다.

고위험 감수 성향을 가진 사용자의 경우, 사실적 설명만 제공했을 때 이해도와 만족도가 모두 높아지는 경향을 보였다. 반면, 반사실적 설명만 제공했을 때에는 이해도가 감소했으나, 만족도는 높은 수준을 유지하였다. 이는 고위험 감수 성향을 가진 사용자의 성격 특성과 관련이 있을 수 있다. 특히, 외향성이 높은 사용자는 직관적 의사결정을 선호하며, 본능과 감정에 기반한 즉각적인 판단을 선호하는 경향이 있다(Nicholson et al., 2005; El Othman et al., 2020). 이러한 성향으로 인해 이해도가 낮더라도 AI가 내린 결과에 대한 만족도를 유지할 수 있었던 것으로 해석된다.

반면, 저위험 감수 성향을 가진 사용자의 경우, 설명 방법에 따른 이해도의 차이가 크지 않았다. 이는 성실성과 관련이 있으며, 성실성이 높은 사용자는 신중하고 체계적인 분석을 통해 의사결정을 내리는 경향이 있다(Nicholson et al., 2005). 이들은 설명 방식에 크게 영향을 받지 않고, 논리적이고 분석적인 접근을 통해 일관된 이해도를 유지하였다(El Othman et al., 2020). 이러한 결과는 저위험 감수 성향 사용자가 금융 의사결정 상황에서 설명 방식에 영향을 덜 받으며, 체계적이고 논리적인 판단을 선호함을 시사한다.

따라서, AI 기반 투자 의사결정 지원 챗봇 설계 시 사용자 맞춤형 설명 방식을 적용하는 것이 중요하다. 고위험 감수 성향을 가진 사용자에게는 직관적인 판단을 지원할 수 있는 간결하고 명확한 설명을 제공하는 것이 만족도와 이해도를 동시에 높이는 데 효과적이다. 반면, 저위험 감수 성향을 가진 사용자에게는 논리적이고 체계적인 설명을 통해 신중한 의사결정을 지원해야 한다. 이러한 사용자 특성 기반의 맞춤형 설명 제공은 사용자 만족도를 높일 뿐만 아니라, AI 기반 금융 의사결정 시스템에 대한 이해도를 증진시키는 데 기여할 수 있다.

본 연구 결과는 사용자의 위험 감수 성향에 따라 설명 방법의 효과가 달라질 수 있음을 확인하였으며, 이는 Alslaity and Tran (2020)의 결과를 지지한다. 특히, 위험 감수 성향이 AI의 결정에 대한 신뢰도에 유의미한 영향을 미친다는 점을 확인하였으며, 이는 사용자 특성이 대화형 추천 시스템에서 신뢰 형성에 중요한 역할을 한다는 Cai et al. (2022)의 연구 결과와 일치한다. 이러한 결과를 토대로, 시스템은 투자자의 위험 감수 성향을 질문을 통해 파악하고, 이를 기반으로 고위험 및 저위험 성향에 맞춘 차별화된 설명 방법의 중요성을 확인할 수 있었다.

투자 의사결정과 같은 개인적 이익과 직접적으로 연관된 상황에서는 시스템과 사용자의 동적 상호작용이 중요하며, 이 과정에서 위험 감수 성향의 영향력이 두드러진다. 본 연구는 개인의 재무적 이익에 직결되는 투자 의사결정 상황을 다루었으나, 선행 연구에 따르면 설명 방법의 효과는 의사결정 맥락에 따라 달라질 수 있다. 예를 들어, Lee and Chew (2023)는 임상 의사결정 환경에서 반사실적 설명이 신뢰와 의존성에 영향을 미친다고 보고하였다. 이러한 맥락적 차이는 설명 방법의 효과성에 영향을 미치는 요인이 될 수 있으며, 본 연구에서도 이와 유사한 경향성이 확인되었다.

본 연구에서는 일부 가설이 지지되지 않았다. 설명 방법은 이해도 향상에는 유의미한 효과를 보였으나, 신뢰도, 만족도, 투자 금액과 같은 사용자 반응과 행동 측면에서는 유의미한 차이가 나타나지 않았다. 이는 투자 의사결정과 같은 개인의 이익에 직접적인 영향을 미치는 상황에서는 설명 방법보다 사용자의 위험 감수 성향이 더 큰 영향을 미치는 것으로 나타났다. 이는 임상 환경과 대조되는 결과로, 임상 의사결정 상황에서는 반사실적 설명이 신뢰에 미치는 영향력이 더 크다는 Lee and Chew (2023)의 연구 결과와 차이를 보인다.

또한, 기존의 P2P 대출에 대한 웹 기반 인터페이스 연구에서는 위험 감수 성향에 따른 투자 금액 차이가 발견되지 않았으나(Dikmen and Burns, 2022), 본 연구에서는 대화형 인터페이스를 적용하여 위험 감수 성향에 따라 투자 금액에 유의미한 차이가 발생함을 확인하였다. 이는 대화형 인터페이스가 웹 기반 시스템보다 사용자의 신뢰와 만족도를 더 높일 수 있다는 기존 연구 결과와 일치한다(Gupta et al., 2022).

따라서, 사용자 특성을 고려한 챗봇 설계는 보다 효과적인 투자 의사결정을 지원할 수 있으며, 특히 위험 감수 성향을 고려한 맞춤형 전략이 필요하다. 이러한 결과를 토대로, 시스템은 맥락을 유지하며 효율적인 상호작용을 유도함으로써 효과적인 의사결정을 지원하는 데 중요함을 확인할 수 있었다.

5.2 Roles of self-reported AI knowledge in investment AI chatbot

본 연구에서는 일부 가설이 완전히 지지되지 않은 원인을 규명하기 위해 위험 감수 성향 외에도 추가적인 성격 특성을 고려하여 분석을 확장하였다. 특히, 사전 설문에서 수집한 사용자 특성과 실험 중 나타난 반응 및 행동 간의 상관관계 분석을 수행하였다. 분석 결과, 주관적인 AI 지식수준은 AI의 결과에 대한 신뢰도(r(113) = .347, p < .001)와 유의미한 양의 상관관계를 보였다. 추가적으로, 투자 경험과 투자 기간은 종속 변수와 유의미한 상관관계를 보이지 않았다.

AI 기반 투자 의사결정 지원 시스템은 사용자들의 주관적인 AI 지식을 고려하여 적절한 설명 방식을 조정할 필요가 있다. 이를 위해 초기 상호작용 시, 사용자에게 주관적인 AI 지식수준을 파악할 수 있는 질문을 제시하고, 그에 맞춰 AI 관련 용어나 설명의 난이도를 조절해야 한다. 본 연구 결과, 사용자의 주관적인 AI 지식수준이 높을수록 AI의 결과에 대한 신뢰도가 유의미하게 증가하는 경향이 확인되었다. 이는 Li et al. (2024)의 결과와 일치하며, AI에 대한 경험이나 지식은 시스템에 대한 신뢰 구축에 중요한 역할을 한다는 점을 시사한다. 또한, AI에 대한 자신감은 AI 기반 시스템 사용 시 신뢰도를 증진시키는 주요 요인으로 작용한다.

사용자들이 AI가 내린 결과를 어떻게 인식하는지에 대한 차이 역시 AI 배경에 따라 달라질 수 있다(Ehsan et al., 2024). AI에 대한 지식이 풍부하다고 생각하는 사용자는 투자 의사결정 지원 챗봇이 제공하는 AI의 결정을 더 신뢰하는 경향이 있다. 이러한 경향은 컴퓨터 자기 효능감(Computer Self-Efficacy, CSE) 개념과 관련이 있을 수 있다. CSE는 사용자가 컴퓨터를 사용할 수 있다고 스스로 평가하는 능력을 의미하며, CSE가 높은 사용자는 시스템에 대한 신뢰도가 더 높은 경향이 있다(Compeau and Higgins, 1995). CSE는 사용자가 컴퓨터를 사용할 수 있다고 스스로 평가하는 능력을 의미하며, CSE가 높은 사용자는 시스템에 대한 신뢰도가 더 높은 경향이 있다. 이는 본 연구에서 나타난 주관적인 AI 지식수준과 신뢰도 간의 양의 상관관계와 부합한다(Madhavan and Phillips, 2010). 또한, 컴퓨터 자기 효능감은 시스템에 대한 최종 사용자 만족도에 긍정적인 영향을 끼친다(Henry and Stone, 1994). 본 연구 결과는 이러한 CSE 연구 결과가 AI 기반 시스템에도 적용될 수 있음을 시사하며, AI에 대한 자기 효능감이 높을수록 투자 의사결정 지원 챗봇에 대한 신뢰도가 증진될 가능성이 있음을 보여준다.

따라서, AI 기반 투자 챗봇 설계 시 사용자의 주관적인 AI 지식수준을 고려한 인터페이스 및 설명 방식을 적용함으로써 사용자의 이해도, 신뢰도, 만족도를 높일 수 있으며, 이는 궁극적으로 사용자 경험 개선으로 이어질 수 있다. 주관적인 AI 지식수준이 높은 사용자에게는 보다 심층적인 AI 작동 방식에 대한 설명을 제공하고, 지식수준이 낮은 사용자에게는 직관적이고 단순화된 설명을 제시함으로써, 다양한 사용자층의 니즈를 충족시킬 수 있을 것이다.

이러한 맞춤형 설명 전략은 투자자의 의사결정 품질을 향상시킬 뿐만 아니라, AI 시스템에 대한 전반적인 수용성도 높일 수 있을 것으로 기대된다. 결과적으로, AI 기반 투자 의사결정 지원 챗봇의 사용자 경험을 개선하고, 시스템에 대한 신뢰도를 강화하는 데 기여할 수 있을 것이다. 이러한 결과를 토대로, 시스템은 투자자의 AI 배경 지식을 질문을 통해 확인하고, AI 관련 용어의 사용을 조정하여 적절한 수준의 설명 제공의 중요성을 확인할 수 있었다.

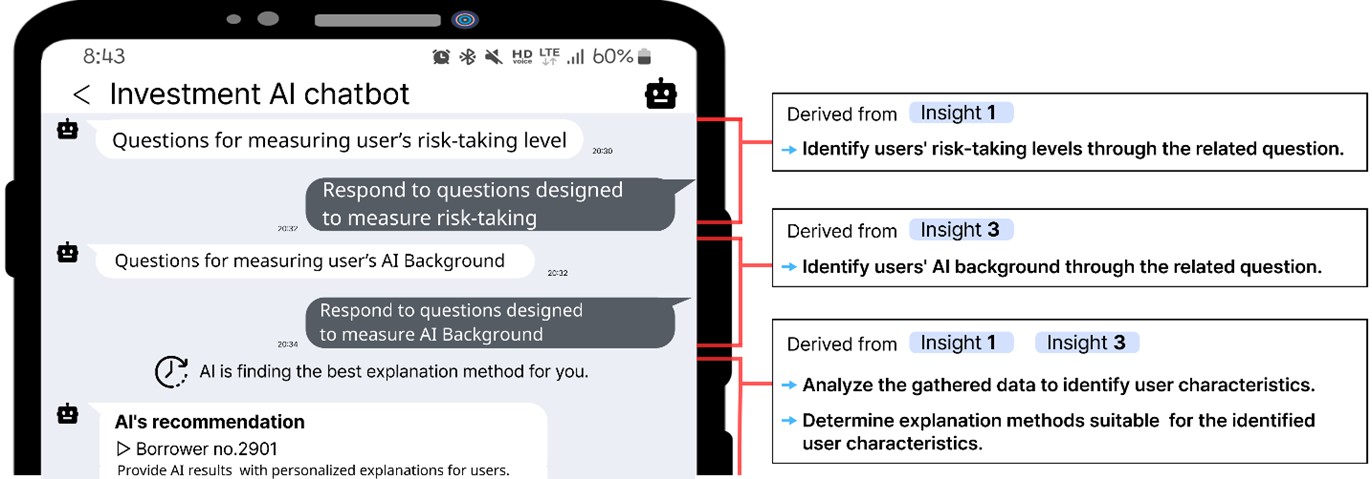

5.3 Design suggestions for a personalized investment AI chatbot

5.1에서 논의한 결과에 따르면 2가지 인사이트를 도출할 수 있다. 첫 번째, 시스템은 투자자의 위험 감수 성향을 질문을 통해 파악하고, 이를 기반으로 고위험 및 저위험 성향에 맞춘 차별화된 설명 방법을 제공해야 한다. 두 번째, 시스템은 맥락을 유지하며 효율적인 상호작용을 유도함으로써 효과적인 의사결정을 지원해야 한다. 또한, 5.2에서 논의한 결과에 따르면 시스템은 투자자의 AI 배경 지식을 질문을 통해 확인하고, AI 관련 용어의 사용을 조정하여 적절한 수준의 설명을 제공해야 한다는 세 번째 인사이트가 도출된다.

앞서 도출된 세 가지 인사이트를 바탕으로, 본 연구는 투자 의사결정 지원 시스템을 위한 인터페이스 설계 방안을 제안한다. 인사이트 2에 근거하여, 금융 의사결정 지원 시스템은 사용자와 시스템 간의 다중 턴 및 지속적인 상호작용을 가능하게 하는 대화형 인터페이스로 설계될 수 있다. 또한, 인사이트 1과 인사이트 3에 따라 시스템은 사용자 특성을 파악하기 위해 관련 질문을 제시하고, 이를 통해 도출된 개인 특성을 설명 방식에 반영한다.

투자 의사결정 지원과 사용자 경험 향상을 위해서는, 사용자 특성에 기반한 실시간 조정이 가능한 AI 기반 대화형 인터페이스 개발이 필요하다. 본 연구는 사용자의 위험 감수 성향과 AI 배경을 고려한 맞춤형 대화형 인터페이스의 필요성을 강조한다. 사용자의 주관적인 AI 지식수준과 위험 감수 성향을 실시간으로 평가할 수 있는 알고리즘을 통해 설명 방법을 조정할 수 있으며, 이를 기반으로 챗봇은 사용자 특성에 맞춘 투자 추천을 제공한다.

Figure 4는 제안하는 맞춤형 핀테크 챗봇의 기본 구조를 나타낸다. 사용자는 초기 단계에서 위험 감수 성향과 AI 배경을 측정하기 위한 질문에 응답하게 되며, 챗봇은 해당 응답을 분석하여 사용자의 특성을 파악한다. 이후, 챗봇은 분석 결과를 바탕으로 사용자의 성향에 맞는 적절한 설명 방식을 선택한다. 예를 들어, 위험 감수 성향이 낮고, 주관적인 AI 지식수준이 높은 사용자는 자세하고 체계적인 설명을 선호할 가능성이 높다. 이러한 사용자를 위해 챗봇은 AI의 의사결정 과정을 단계별로 설명하고, 기술적 세부사항과 분야별 AI 용어를 포함하여 논리적이고 체계적인 설명을 제공할 수 있다. 이는 사용자의 합리적 의사결정 스타일에 부합하며, AI 시스템에 대한 이해도와 신뢰도를 증진시킬 수 있다. 챗봇은 사용자 특성에 기반한 맞춤형 투자 추천을 통해 사용자가 보다 정보에 근거한 의사결정을 내릴 수 있도록 지원하며, 동시에 정보 처리 효율성을 높인다. 이러한 맞춤형 설명 전략은 사용자와 시스템 간의 신뢰도, 이해도, 만족도를 증진시켜, 투자 의사결정 지원 챗봇의 전반적인 효과성을 강화할 수 있다.

결론적으로, 본 연구는 사용자 특성에 맞춘 AI 기반 대화형 인터페이스가 투자 의사결정 과정에서의 사용자 경험을 개선할 수 있음을 시사한다. 특히, 위험 감수 성향과 주관적인 AI 지식수준을 고려한 설명 전략을 통해, 사용자의 신뢰와 만족도를 향상시키고, 보다 효율적인 금융 의사결정을 지원할 수 있을 것으로 기대된다. 이러한 접근 방식은 금융 기관이 다양한 사용자 프로필에 맞춘 AI 기반 챗봇을 설계하는 데 있어 유용한 전략을 제공할 것이다.

5.4 Limitations

본 연구는 P2P 대출 시나리오를 기반으로 한 시뮬레이션 투자 상황에서 참가자들의 투자 행동을 분석하였다는 점에서 실제 투자 상황과 차이가 존재할 수 있다는 한계점이 존재한다. Şenol and Onay (2023)은 동일한 투자자라도 실제 투자 상황과 시뮬레이션 투자 상황에서 서로 다른 행동 편향을 보인다고 보고한 바 있다. 또한, 참가자들이 실제 금전적 손실이나 책임을 지지 않기 때문에 현실에서의 행동을 재현하는 데 한계가 존재한다. 그러나 본 연구에서는 이러한 차이에도 불구하고 고위험 감수 집단이 저위험 감수 집단보다 유의미하게 더 많은 금액을 투자하는 경향을 보였다. 우리는 실험 환경이 실제 금융 의사결정에서의 행동 패턴을 반영할 수 있도록 위험 감수 성향을 사전에 평가하고, 이를 바탕으로 참가자를 분류해 실험을 설계했다. 또한, 실제 P2P 대출 데이터를 사용하여 AI의 결과를 도출했으며, 웹 기반의 챗봇을 제작하여 실제 투자 상황과 유사한 실험 환경을 구축하였다. 이를 바탕으로 실험을 진행하여 고위험 감수 성향과 저위험 감수 성향 간 차이가 드러났으며, 시뮬레이션 투자 상황이지만 실제 패턴을 반영하였음을 나타낸다. 이는 위험 감수 성향이 투자 행동에 영향을 끼친다는 기존 연구(Keller and Siegrist, 2006; Hyll and Irrek, 2015)의 결과를 지지한다. 이러한 결과는 본 연구가 실제 금융 의사결정에서 나타날 수 있는 사용자의 행동 패턴을 반영하고 있음을 보여준다. 향후 연구에서는 실제 투자 환경을 기반으로 하여 금전적 인센티브를 포함한 실험 설계를 도입하여 사용자 행동의 현실성과 타당성을 보다 강화할 수 있을 것이다.

본 연구는 사용자의 위험 감수 성향과 설명 방법이 사용자 반응과 행동에 미치는 영향을 분석하였다. 연구 결과, 사용자의 위험 감수 성향은 AI의 결과에 대한 신뢰도, 만족도, 그리고 투자 금액에 유의미한 영향을 미치는 것으로 나타났다. 특히, 고위험 감수 성향을 가진 사용자는 이해도보다는 직관적 의사결정에 더 중점을 두는 경향을 보였다. 또한, 주관적인 AI 지식수준이 사용자 경험에 중요한 영향을 미치는 것으로 확인되었다. 주관적인 AI 지식수준이 높은 사용자는 AI의 결정에 대한 신뢰도가 더 높은 경향을 보였으며, 이는 사용자의 AI 배경이 AI 시스템과의 상호작용에 있어 중요한 요인임을 시사한다. 이러한 결과는 사용자 특성에 기반한 맞춤형 AI 설명 전략의 필요성을 강조하며, 금융 분야에서의 AI 기반 시스템 설계에 유의미한 시사점을 제공한다.

본 연구 결과는 금융 기관이 다양한 사용자 특성을 고려한 AI 기반 챗봇을 개발하는 데 기여할 수 있으며, 이를 통해 사용자 경험과 의사결정 과정을 개선할 수 있을 것으로 기대된다. 특히, 사용자 개별 특성에 맞춘 설명 방식을 통해 보다 효과적인 상호작용이 가능해지며, 이는 실제 금융 의사결정 환경에서의 활용성을 높일 수 있다. 본 연구는 사용자 중심의 AI 설명 전략이 금융 의사결정 지원 시스템에서 중요한 역할을 할 수 있음을 강조하며, 사용자 특성에 맞춘 설명이 AI 시스템에 대한 신뢰도와 만족도를 향상시킬 수 있음을 보여준다. 향후 연구에서는 본 연구에서 제안한 AI 기반 투자 의사결정 지원 챗봇의 효과성을 평가하고, 실제 금융 환경에서의 적용 가능성을 탐색할 예정이다.

References

1. Ainia, N.S.N. and Lutfi, L., "The influence of risk perception, risk tolerance, overconfidence, and loss aversion towards investment decision making", Journal of Economics, Business, & Accountancy Ventura, 21(3), 401-413, 2019, doi:10.14414/jebav.v21i3.1663.

Google Scholar

2. Alslaity, A. and Tran, T., "The Effect of Personality Traits on Persuading Recommender System Users", IntRS@ RecSys (pp. 48-56), Virtual Event, 2020.

Google Scholar

3. Bachmann, A., Becker, A., Buerckner, D., Hilker, M., Kock, F., Lehmann, M., Tiburtius, P. and Funk, B., "Online peer-to-peer lending-a literature review", Journal of Internet Banking and Commerce, 16(2), 2011.

Google Scholar

4. Bertrand, A., Eagan, J.R. and Maxwell, W., "Questioning the ability of feature-based explanations to empower non-experts in robo-advised financial decision-making", Proceedings of the 2023 ACM Conference on Fairness, Accountability, and Transparency (pp. 943-958), Chicago. IL, 2023, doi:10.1145/3593013.3594053.

Google Scholar

5. Bove, C., Aigrain, J., Lesot, M.J., Tijus, C. and Detyniecki, M., "Contextualization and exploration of local feature importance explanations to improve understanding and satisfaction of non-expert users", Proceedings of the 27th International Conference on Intelligent user Interfaces (pp. 807-819), Helsinki, 2022, doi:10.1145/3490099.3511139.

Google Scholar

6. Bove, C., Lesot, M.J., Tijus, C.A. and Detyniecki, M., "Investigating the intelligibility of plural counterfactual examples for non-expert users: an explanation user interface proposition and user study", Proceedings of the 28th International Conference on Intelligent User Interfaces (pp. 188-203), Sydney, 2023, doi:10.1145/3581641.3584082.

Google Scholar

7. Brown, S. and Taylor, K., "Household finances and the 'Big Five'personality traits", Journal of Economic Psychology, 45, 197-212, 2014.

Google Scholar

8. Cai, W., Jin, Y. and Chen, L., "Impacts of personal characteristics on user trust in conversational recommender systems", Proceedings of the 2022 CHI Conference on Human Factors in Computing Systems (pp. 1-14), New Orleans. LA, 2022, doi:10.1145/ 3491102.3517471.

Google Scholar

9. Chatti, M.A., Guesmi, M., Vorgerd, L., Ngo, T., Joarder, S., Ain, Q.U. and Muslim, A., "Is more always better? The effects of personal characteristics and level of detail on the perception of explanations in a recommender system", In Proceedings of the 30th ACM Conference on User Modeling, Adaptation and Personalization (pp. 254-264), 2022.

Google Scholar

10. Compeau, D.R. and Higgins, C.A., "Computer self-efficacy: Development of a measure and initial test", MIS Quarterly, 189-211, 1995.

Google Scholar

11. Dikmen, M. and Burns, C., "The effects of domain knowledge on trust in explainable AI and task performance: A case of peer-to-peer lending", International Journal of Human-Computer Studies, 162, 102792, 2022, doi:10.1016/j.ijhcs.2022.102792.

Google Scholar

12. Ehsan, U., Passi, S., Liao, Q.V., Chan, L., Lee, I.H., Muller, M. and Riedl, M.O., "The Who in XAI: How AI Background Shapes Perceptions of AI Explanations", Proceedings of the CHI Conference on Human Factors in Computing Systems (pp. 1-32), Honolulu. HI, 2024.

Google Scholar

13. El Othman, R., El Othman, R., Hallit, R., Obeid, S. and Hallit, S., "Personality traits, emotional intelligence and decision-making styles in Lebanese universities medical students", BMC Psychology, 8, 1-14, 2020, doi:10.1186/s40359-020-00406-4.

Google Scholar

14. Guo, L., Daly, E.M., Alkan, O., Mattetti, M., Cornec, O. and Knijnenburg, B., "Building trust in interactive machine learning via user contributed interpretable rules", Proceedings of the 27th International Conference on Intelligent user Interfaces (pp. 537-548), Helsinki, 2022, doi:10.1145/3490099.3511111.

Google Scholar

15. Gupta, A., Basu, D., Ghantasala, R., Qiu, S. and Gadiraju, U., "To trust or not to trust: How a conversational interface affects trust in a decision support system", Proceedings of the ACM Web Conference 2022 (pp. 3531-3540), Lyon, 2022, doi:10.1145/ 3485447.3512248.

Google Scholar

16. Henry, J.W. and Stone, R.W., "A structural equation model of end-user satisfaction with a computer-based medical information system", Information Resources Management Journal (IRMJ), 7(3), 21-33, 1994.

Google Scholar

17. Hernandez-Bocanegra, D.C., Donkers, T. and Ziegler, J., "Effects of argumentative explanation types on the perception of review-based recommendations", In Adjunct Publication of the 28th ACM Conference on User Modeling, Adaptation and Personalization (pp. 219-225), 2020.

Google Scholar

18. Hoffman, R.R., Mueller, S.T., Klein, G. and Litman, J., "Metrics for explainable AI: Challenges and prospects", arXiv preprint arXiv: 1812.04608, 2018.

Google Scholar

19. Hsiao, J.H.W., Ngai, H.H.T., Qiu, L., Yang, Y. and Cao, C.C., "Roadmap of designing cognitive metrics for explainable artificial intelligence (XAI)", arXiv preprint arXiv:2108.01737, 2021.

Google Scholar

20. Hyll, W. and Irrek, M, "The impact of risk attitudes on financial investments", IWH Discussion Papers, 10, 2015.

Google Scholar

21. Keller, C. and Siegrist, M., "Investing in stocks: The influence of financial risk attitude and values-related money and stock market attitudes", Journal of Economic Psychology, 27(2), 285-303, 2006.

Google Scholar

22. Kouki, P., Schaffer, J., Pujara, J., O'Donovan, J. and Getoor, L., "Personalized explanations for hybrid recommender systems", Proceedings of the 24th International Conference on Intelligent user Interfaces, (pp. 379-390), New York. NY, 2019, doi:10.1145/ 3301275.3302306.

Google Scholar

23. Lee, M.H. and Chew, C.J., "Understanding the effect of counterfactual explanations on trust and reliance on ai for human-ai collaborative clinical decision making", Proceedings of the ACM on Human-Computer Interaction, 7(pp. 1-22), Singapore, 2023, doi:10.1145/3610218.

Google Scholar

24. Li, Y., Wu, B., Huang, Y. and Luan, S., "Developing trustworthy artificial intelligence: insights from research on interpersonal, human-automation, and human-AI trust", Frontiers in Psychology, 15, 1382693, 2024, doi:10.3389/fpsyg.2024.1382693.

Google Scholar

25. Madhavan, P. and Phillips, R.R., "Effects of computer self-efficacy and system reliability on user interaction with decision support systems", Computers in Human Behavior, 26(2), 199-204, 2010, doi:10.1016/j.chb.2009.10.005.

Google Scholar

26. Meman, M.U. and Chouhan, P.M., "Big Five Personality Traits and Investment Decision". Turkish Online Journal of Qualitative Inquiry, 12(9), 896-905, 2021.

Google Scholar

27. Mothilal, R.K., Sharma, A. and Tan, C., "Explaining machine learning classifiers through diverse counterfactual explanations", Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency, Barcelona, 2020.

Google Scholar

28. Mubaraq, M.R., Anshori, M. and Trihatmoko, H., "The influence of financial knowledge and risk tolerance on investment decision making", Jurnal Ekonomi Bisnis Dan Kewirausahaan, 10(2), 2021, doi:10.26418/jebik.v10i2.47089.

Google Scholar

29. Nicholson, N., Soane, E., Fenton-O'Creevy, M. and Willman, P., "Personality and domain-specific risk taking", Journal of Risk Research, 8(2), 157-176, 2005, doi:10.1080/1366987032000123856.

Google Scholar

30. Oxera, The Economics of Peer-to-Peer Lending, Technical Report (Retrived from 2016).

31. Pedreschi, D., Giannotti, F., Guidotti, R., Monreale, A., Ruggieri, S. and Turini, F., "Meaningful explanations of black box AI decision systems", In Proceedings of the AAAI Conference on Artificial Intelligence, 33(pp. 9780-9784), 2019.

Google Scholar

32. Rai, A, "Explainable AI: From black box to glass box", Journal of the Academy of Marketing Science, 48, 137-141, 2020.

Google Scholar

33. Regulation, General Data Protection. https://eur-lex. europa.eu/legal-content/IT/TXT (Retrived from April 27, 2016).

34. Ribeiro, M.T., Singh, S. and Guestrin, C., "Why should i trust you?" Explaining the predictions of any classifier". Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining (pp. 1135-1144), San Francisco, 2016.

Google Scholar

35. Ribeiro, M.T., Singh, S. and Guestrin, C., "Anchors: High-precision model-agnostic explanations". Proceedings of the AAAI Conference on Artificial Intelligence, 32(1), 2018.

Google Scholar

36. Sachdeva, M. and Lehal, R., "The influence of personality traits on investment decision-making: a moderated mediation approach", International Journal of Bank Marketing, 41(4), 810-834, 2023.

Google Scholar

37. Saurabh, K. and Nandan, T., "Role of financial risk attitude and financial behavior as mediators in financial satisfaction: Empirical evidence from India", South Asian Journal of Business Studies, 7(2), 207-224, 2018.

Google Scholar

38. Schoeffer, J., Kuehl, N. and Machowski, Y., ""There is not enough information": On the effects of explanations on perceptions of informational fairness and trustworthiness in automated decision-making", Proceedings of the 2022 ACM Conference on Fairness, Accountability, and Transparency (pp. 1616-1628), Seoul, 2022, doi:10.1145/3531146.3533218.

Google Scholar

39. Şenol, D. and Onay, C., "Impact of gamification on mitigating behavioral biases of investors", Journal of Behavioral and Experimental Finance, 37, 100772, 2023.

Google Scholar

40. Szymanski, M., Millecamp, M. and Verbert, K., "Visual, textual or hybrid: the effect of user expertise on different explanations", Proceedings of the 26th International Conference on Intelligent User Interfaces (pp. 109-119), College Station, 2021, doi:10.1145/ 3397481.3450662.

Google Scholar

41. Treich, N., "Risk tolerance and value of information in the standard portfolio model", Economics Letters, 55(3), 361-363, 1997.

Google Scholar

42. Weber, M., Weber, E.U. and Nosić, A., "Who takes risks when and why: Determinants of changes in investor risk taking", Review of Finance, 17(3), 847-883, 2013, doi:10.1093/rof/rfs024.

Google Scholar

43. Wu, W.Y. and Chang, M.L., "The role of risk attitude on online shopping: Experience, customer satisfaction, and repurchase intention", Social Behavior and Personality: an International Journal, 35(4), 453-468, 2007.

Google Scholar

PIDS App ServiceClick here!